2024-10-01(TUE)

(1) 금일 진행

- vCenter Server Configuration

- Virtual Networking

- Storage Configuration

1. vCenter Server Configuration

1-1. 실습 이전 확인 사항

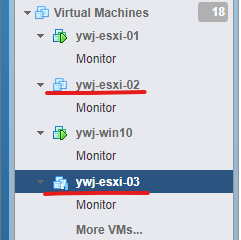

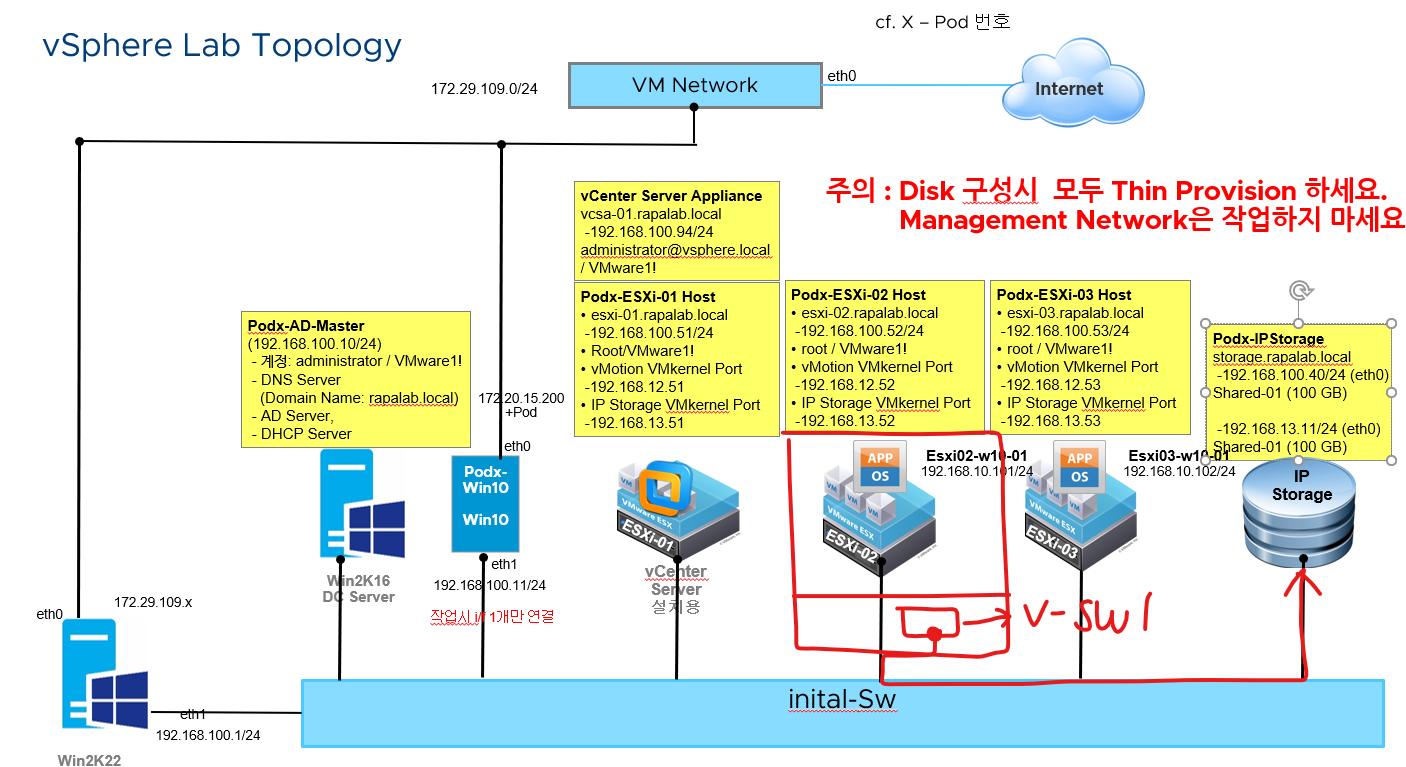

(1) ESXi-02, 03 호스트에 대해서 vCenter Server에 등록해서 중앙 집중 형식으로 관리할 것이기 때문에 호스트의 전원은 켜둔다.

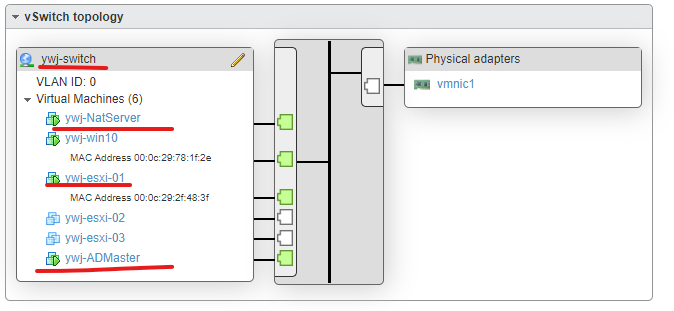

(2) 개인 가상 스위치에도 서비스를 위한 VM들이 활성화되어 있는지 체크한다.

- 현재 전원이 OFF 상태이므로 전원은 켜둔다.

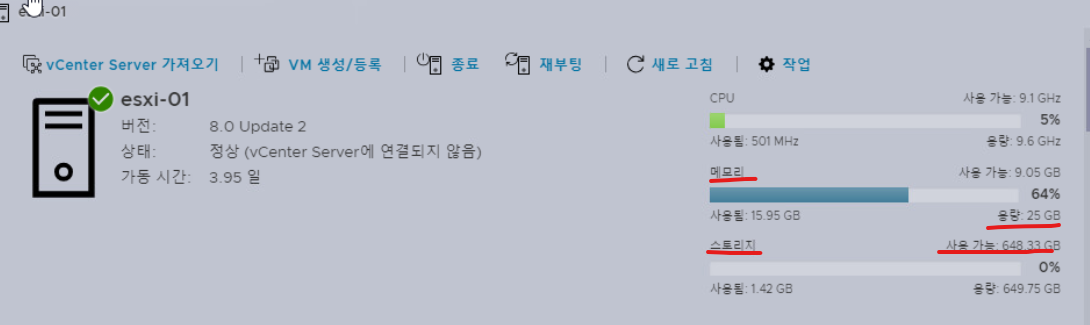

1-2. ESXi-01 접속

(1) 현재 작업한 내용이 없어서 호스트의 자원을 거의 사용하지 않았다.

1-3. vSphere Topology - 작업할 내용들 확인

1-4. vCenter Server 접속 후 작업 - esxi-02, 03 호스트 등록

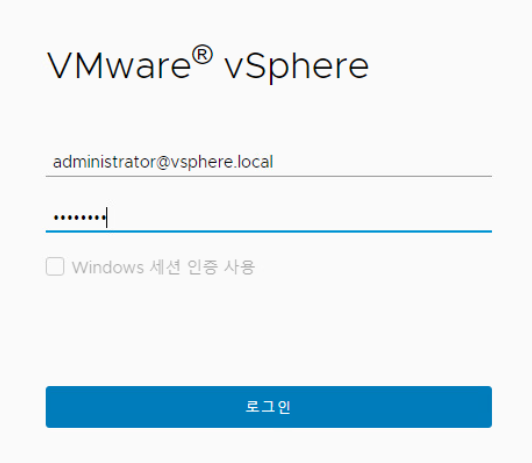

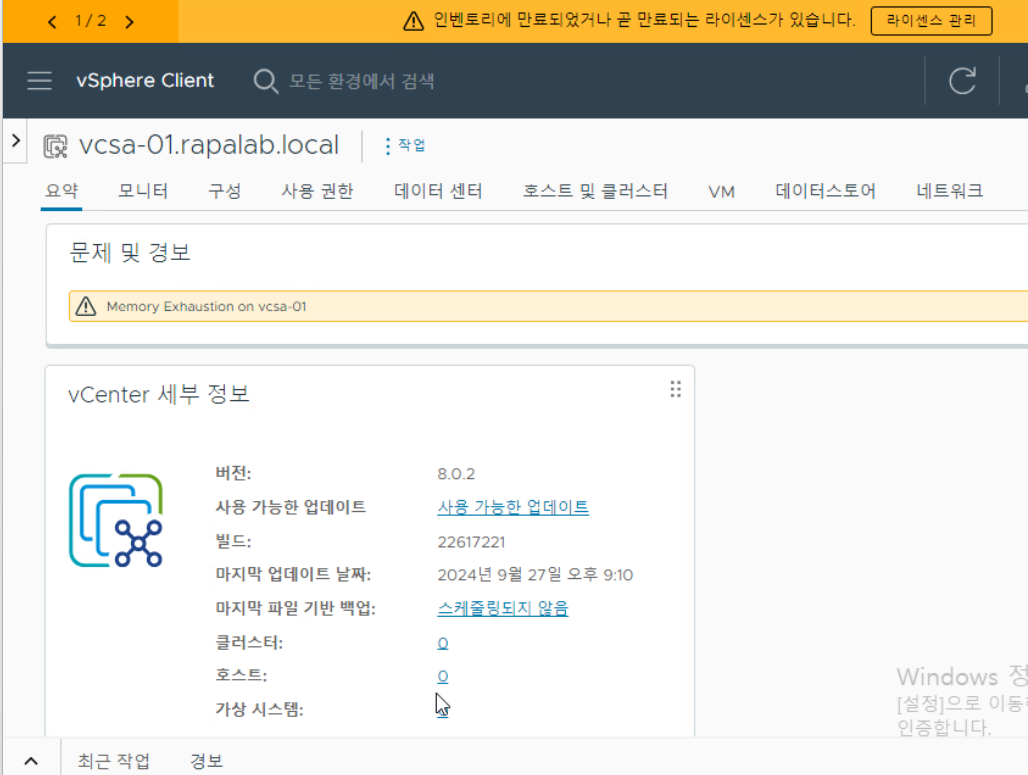

(1) SSO 인증 계정을 통해 vCenter Server(vSphere Client)에 접속한다.

(2) vSphere 인벤토리에 접속한 화면이다.

(3) 생성된 호스트(VM)에 대한 정보이다.

(4) 나머지 영역에 대한 정보들이다. (왼쪽부터 호스트(VM), OVF 템플릿, 스토리지 정보, 네트워크 정보)

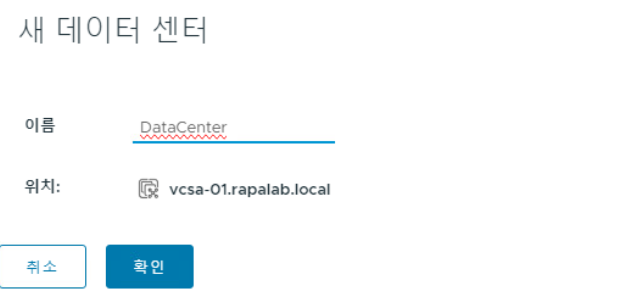

(5) 새로운 데이터 센터 생성을 클릭한다.

(6) 데이터 센터 생성 메뉴에서 이름을 위와 같이 부여한다.

(7) 새로운 데이터 센터가 생성되었다.

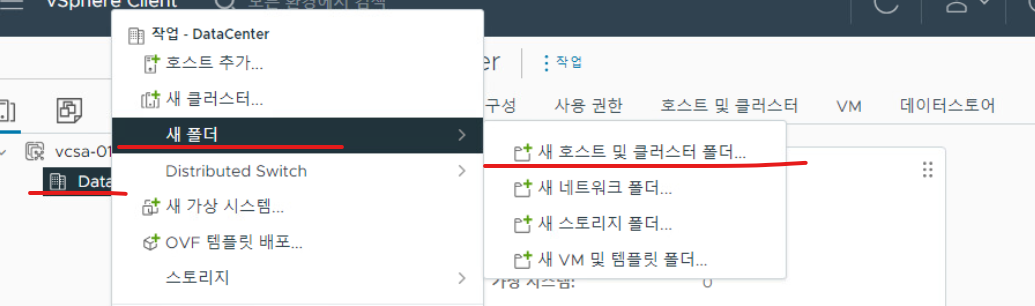

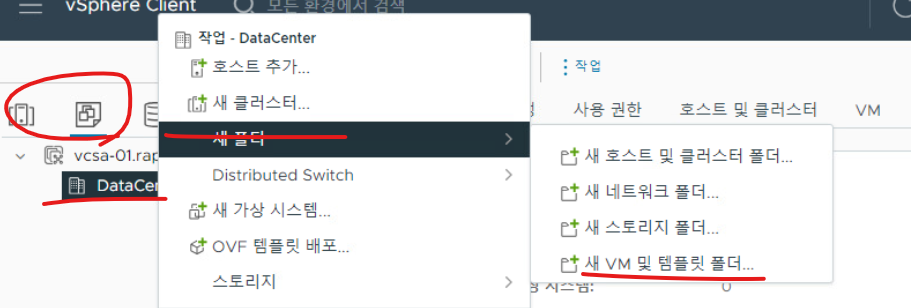

(8) 호스트를 추가하기 전, 호스트 메뉴에서 "새 호스트 및 클러스터 폴더"를 누르고 새로운 폴더를 생성한다.

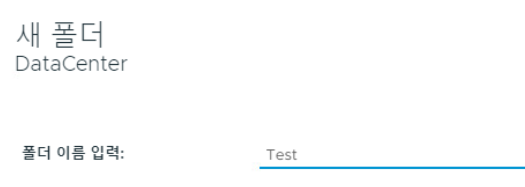

(9) 위와 같이 폴더명을 부여한다.

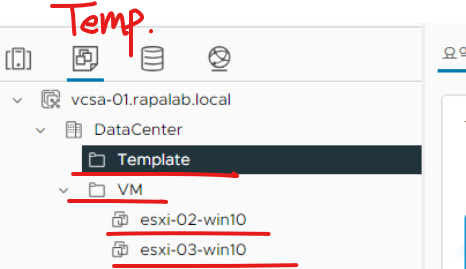

(10) 이번에는 템플릿 영역에서 새로운 폴더를 추가한다.

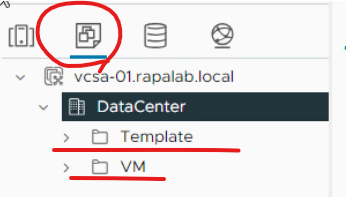

(11) Template, VM 이름으로 두 개의 폴더를 추가한다.

(12) 클러스터는 시스템을 하나로 묶어서 관리하는 개념이라고 우선 생각해 둔다.

* 클러스터(Cluster) : 여러 대의 물리적 서버를 하나의 논리적 그룹으로 묶어서 자원 관리 및 가용성을 향상 시키는 구조를 의미한다.

(13) OVF 템플릿 배포의 경우 가상 머신을 만들고 이를 표준화된 포맷 템플릿으로 만들어서 가상 머신을 빠르게 배포할 수 있다. ( OVF 템플릿 배포를 통해 특정 VM의 구성 및 설정 정보를 표준화된 포맷으로 패키징하여 저장한다.)

* OVF (Open Virtualization Format) Template Deployment는 가상 머신을 배포하는 데 사용되는 표준화된 형식을 의미한다. OVF는 가상 머신의 구성, 소프트웨어, 하드웨어 설정을 포함하는 패키지로 여러 가상화 플랫폼 간의 상호 운용성을 제공한다.

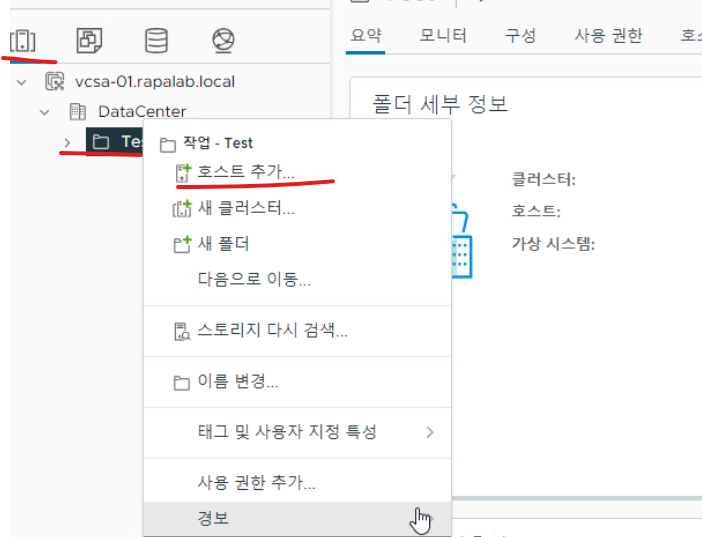

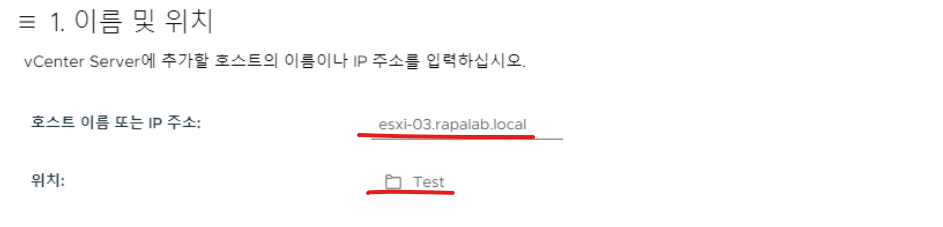

(14) 생성한 호스트 탭의 Test 폴더에서 "호스트 추가"를 클릭한다.

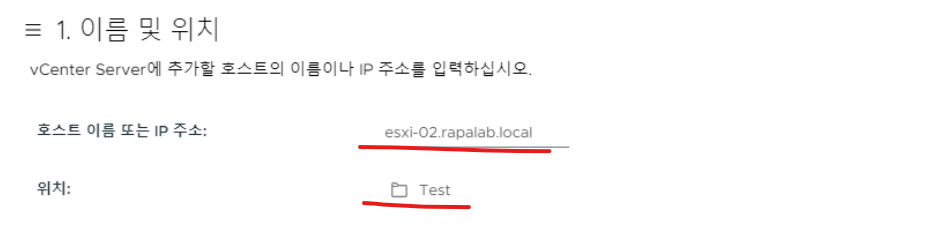

(15) 호스트명을 esxi-02.rapalab.local로 지정한다.

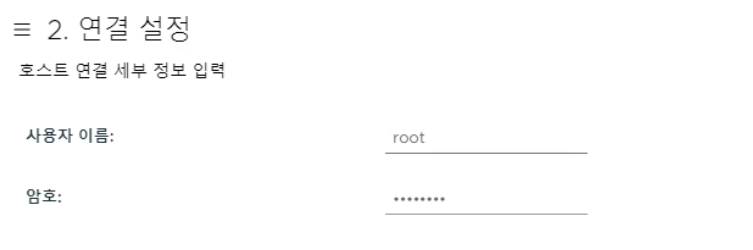

(16) 사용자명을 관리자로 주고 암호를 지정한다.

(17) 보안 경고에서 나타나는 인증서 미확인 메시지는 "예"로 넘어간다.

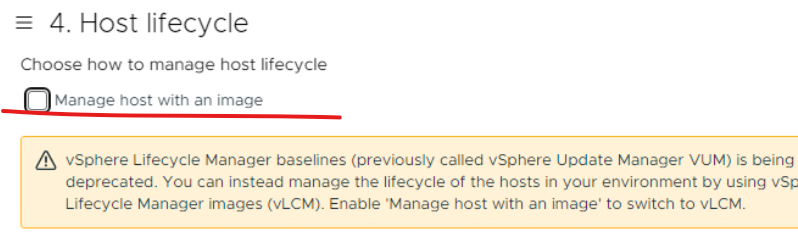

(18) Manage host with an image 옵션은 해제한다.

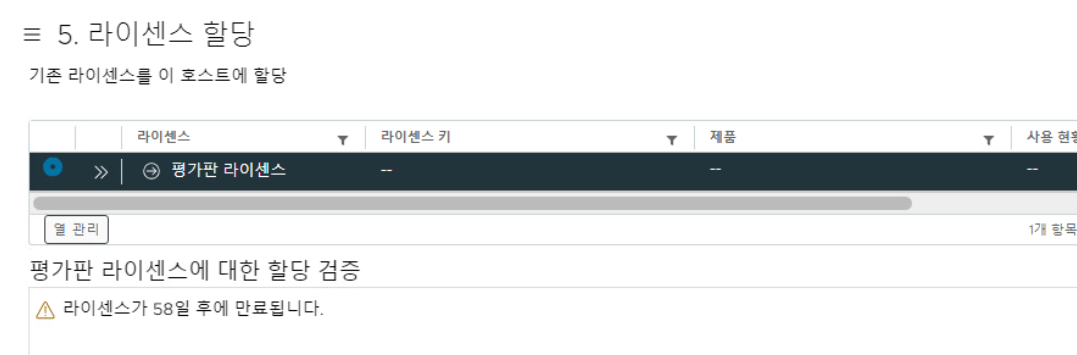

(19) 라이센스는 평가판으로 할당한다.

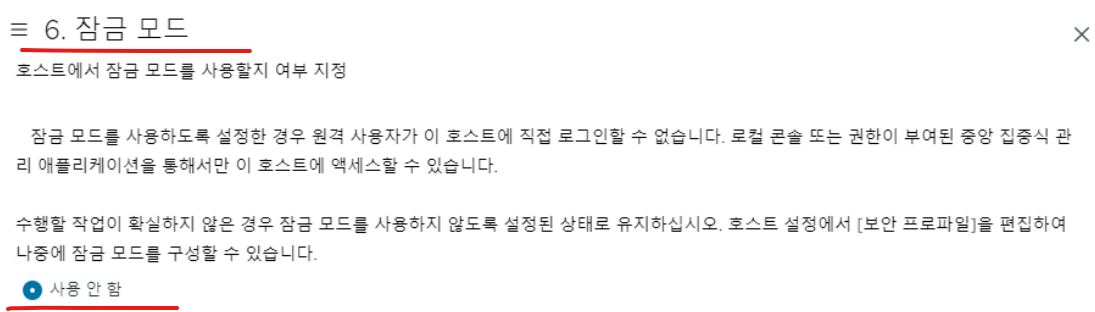

(20) 원격 접속 사용을 위해 잠금 모드는 Disabled 한다.

(21) 호스트의 위치를 데이터 센터 하단으로 선택한다.

(22) 설정 정보를 마지막 단계에서 확인한다.

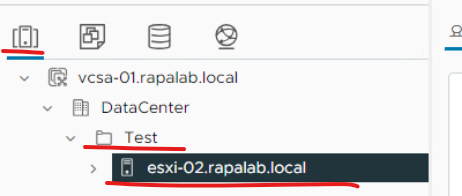

(23) 호스트 정보로 조회하면 DataCenter > Test 디렉터리에 esxi-02.rapalab.local 호스트가 새로 생성된 것을 확인할 수 있다.

(24) ESXi-03 호스트도 위와 같은 방식으로 추가한다.

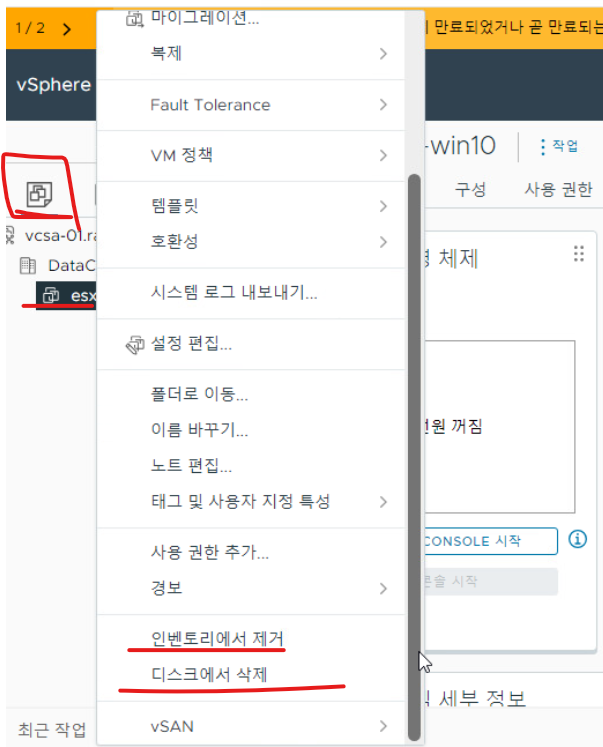

(25) 디스크 삭제의 경우 생성된 VM에 대해 VM의 부팅 디스크를 삭제한다는 의미를 갖는다.

(26) 가상화에서 인벤토리 삭제는 가상화 관리 플랫폼 내에서 가상 머신, 데이터스토어, 네트워크 등과 같은 자원을 관리하기 위한 인벤토리(목록)에서 특정 항목을 제거하는 과정을 의미한다.

(27) 현재 호스트(VM), 호스트에 대한 운영체제 템플릿, 데이터스토어가 모두 확인된다.

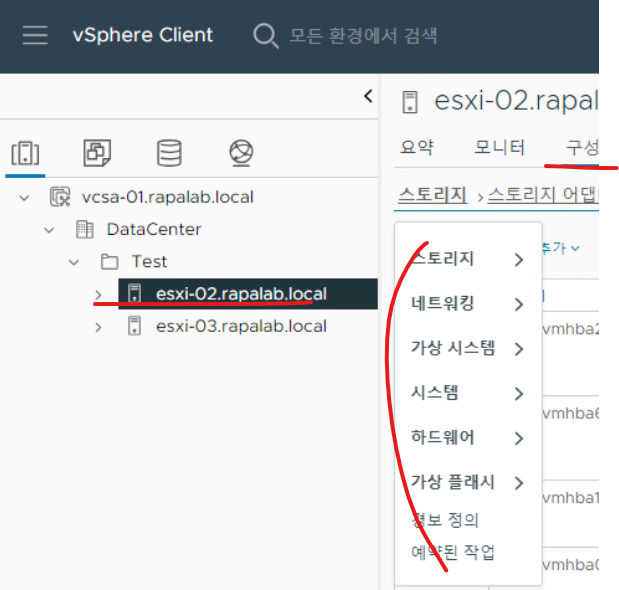

(28) 생성한 호스트에 대해 우측 영역에서 스토리지, 네트워킹, VM 등에 대해 여러 가지 세부 작업을 수행할 수 있다.

2. VMware vCenter Server : Client Architecture, Single-Sign-On

2-1. vCenter Client Architecture

2-2. vCenter Single-Sign-On Information

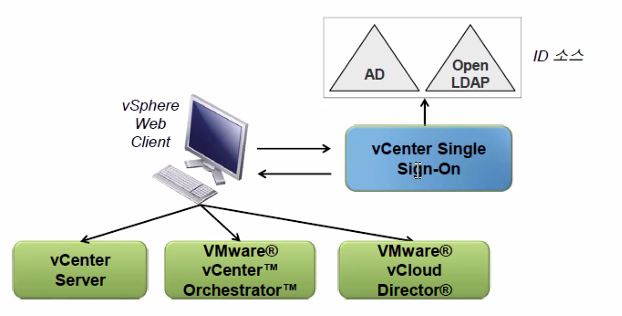

(1) vCenter Single-Sign-On은 VMware 클라우드 인프라 플랫폼의 보안을 유지할 수 있는 인증 서비스를 의미한다.

(2) vCenter Single-Sign-On을 사용하면 vSphere 소프트웨어 구성 요소가 보안 토큰 매커니즘을 통해 서로 통신할 수 있게 된다.

2-3. vCenter Single-Sign-On의 이점

- vCenter Single-Sign-On을 사용하면 아래와 같은 이점을 가진다.

(1) 보다 빠른 작업 환경 제공 & 간소화된 인증 프로세스를 제공한다.

(2) 솔루션에 액세스 시 인증을 요구하지 않고 vCenter 솔루션이 상호 신뢰를 할 수 있게 된다.

(3) 다중 인스턴스 및 다중 사이트 구성을 지원하는 아키텍처를 통해 전체 환경에서 단일 솔루션 인증을 제공한다.

2-4. vCenter Single-Sign-On의 기능

(1) vCenter Single-Sign-On은 여러 가지 기능을 제공한다.

(2) 개방형 표준 지원

(3) Active Directory 및 OpenLDAP를 비롯한 여러 사용자 지정소 지원

(4) 사용자가 권한이 있는 모든 vCenter Server 인스턴스를 볼 수 있다.

(5) vCenter Server 인스턴스의 통합 보기에 vCenter Linked Mode를 사용할 필요가 없다.

* vCenter Linked Mode는 VMware vCenter Server의 기능으로, 여러 vCenter 인스턴스를 연결하여 단일 관리 인터페이스에서 통합적으로 관리한다.

2-5. 기본 배포 모드

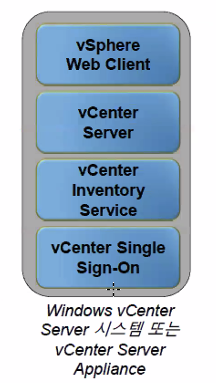

(1) 기본 모드의 경우 가장 일반적인 배포 옵션이다.

(2) Simple Install 옵션을 사용해서 vCenter Single-Sign-On과 함께 vCenter Server를 기본 모드로 배포할 수 있다.

(3) 기본 모드는 다음과 같은 상황에서 적합하다.

- 최대 1,000대의 호스트 또는 10,000대의 VM으로 구성된 인벤토리의 단일 vCenter Server 인스턴스를 사용하려는 경우

- 서로 독립적으로 관리되고 지리적으로 분산된 vCenter Server 인스턴스를 사용하려는 경우

- vCenter Serverappliance를 사용하려는 경우

2-6. 동일한 위치에서의 Single Sign on 인스턴스

(1) 동일한 위치에서의 SSO 인스턴스인 해당 배포 모드는 SSO 환경에서 고가용성을 제공한다.

(2) VMware vSphere High Availability 또는 VMware vCenter Server Hearbeat를 사용할 계획은 없지만 vCenter SSO 서버의 고가용성 환경이 필요한 경우 해당 모드를 사용한다.

2-6. 서로 다른 위치의 여러 Single-Sign-on 인스턴스

(1) 서로 다른 위치에서의 SSO 인스턴스는 vCenter Server 시스템이 지리적으로 분산되어 있고 여러 인스턴스를 Linked Mode에서 관리해야 하는 경우 필요하다.

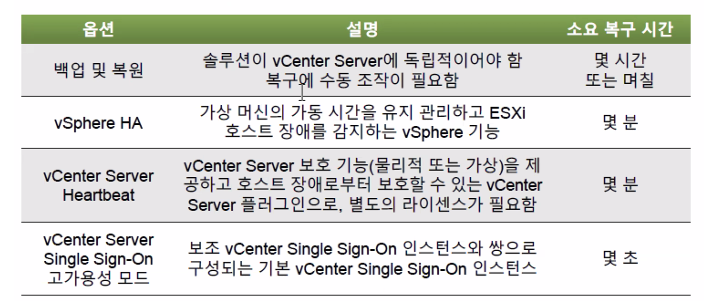

2-7. Single Sign on - 가용성 보장을 위한 여러 가지 방법

(1) VMware vSphere에서는 vCenter SSO와 함께 배포된 vSphere의 가용성을 보장하는 여러 가지 방법을 위와 같이 제공하고 있다.

3. VMware vCenter Server Inventory Management

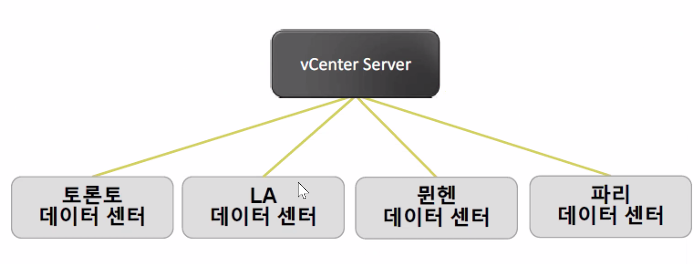

3-1. 데이터 센터 객체

(1) 각 데이터 센터에는 고유한 호스트, VM, 템플릿, 데이터 스토어 및 네트워크 등 가상화 환경을 이루는 요소들이 존재한다.

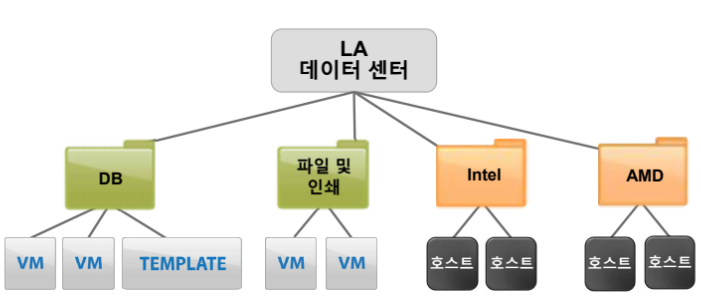

3-2. 인벤토리 객체를 폴더로 객체 형태로 구성

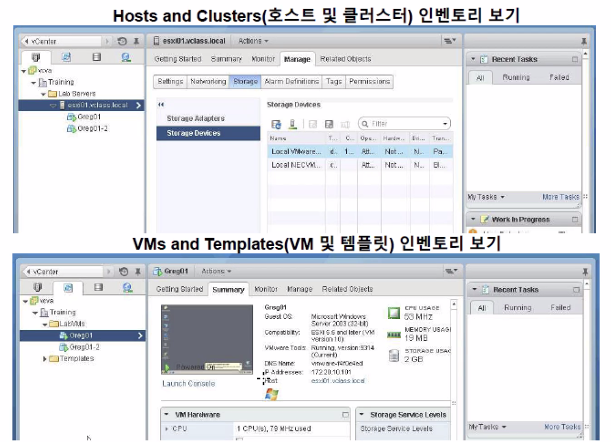

3-3. vCenter Server 보기 : Host and Clusters & VMs and Templates

3-4. vCenter Server에서의 라이센스 개요

(1) vCenter Server에서 라이센스를 관리하고 모니터링할 수 있다.

(2) 라이센스는 다음과 같은 항목으로 구성된다.

- 제품 : vSphere 소프트웨어 구성 요소 또는 기능을 사용하기 위한 라이센스

- 라이센스 키 : 제품에 해당하는 25자리 문자열

- 자산 : 제품이 설치된 시스템

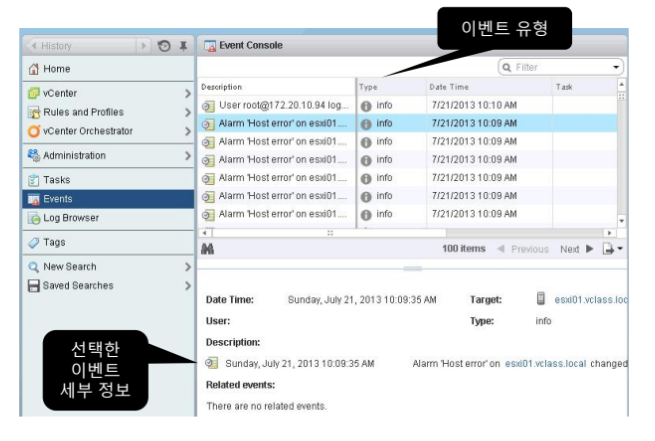

3-5. vCenter Server 이벤트 로그 기록 확인

4. VMware Virtual Networking Configuration : 표준 스위치 소개

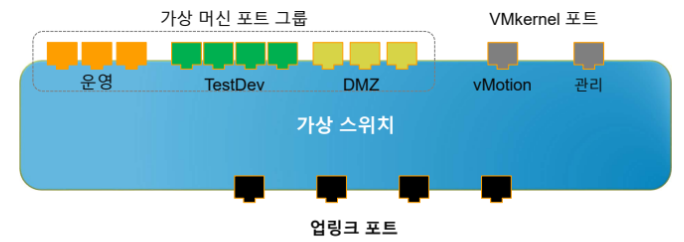

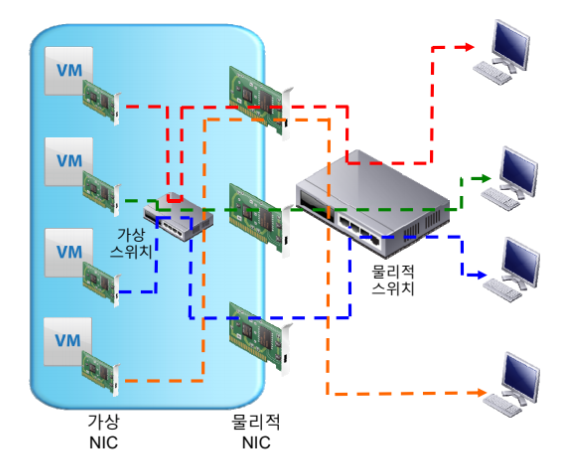

4-1. 가상 스위치 연결 유형

- 가상 스위치는 다음 연결 유형을 허용한다.

(1) 가상 머신 포트 그룹

(2) VMKernel 포트 : VMkernel 포트는 VMware ESXi 호스트에서 특정한 작업들을 처리하기 위해 설계된 가상화 네트워크 트래픽을 허용하는 특정 인터페이스를 의미한다.

- IP Storage, vSphere vMotion Migration & VMware vSphere Fault Tolerance용

- ESXi 관리 네트워크용

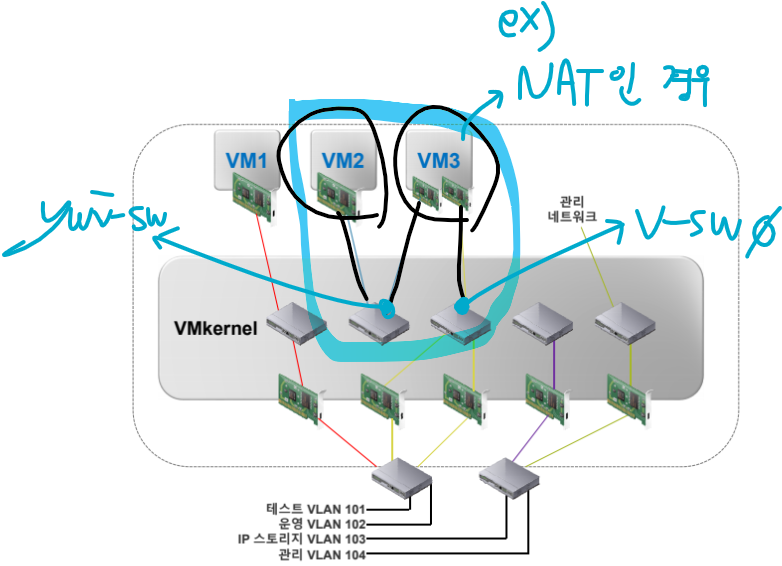

4-2. 가상 스위치 연결 예시

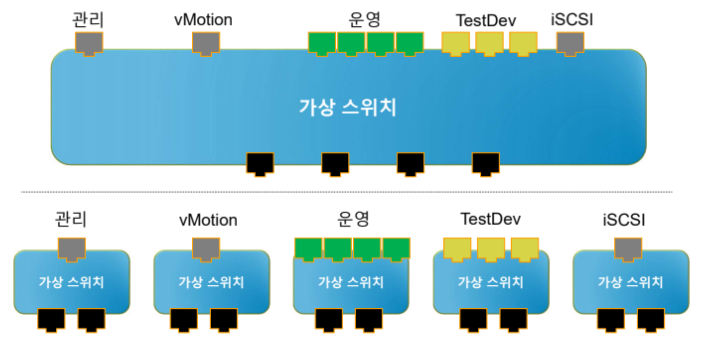

(1) 가상 스위치 구성의 경우, 둘 이상의 네트워크가 동일한 가상 스위치에 존재하거나 개별 가상 스위치에 존재할 수 있다.

4-3. 가상 스위치 유형

- 가상 네트워크는 다음 두 가지 유형의 가상 스위치를 제공한다.

(1) vNetwork 표준 스위치

- 단일 호스트용 가상 스위치 구성

(2) vNetwork Distributed Switch

- 여러 호스트에서 마이그레이션 할 때 가상 스위치의 일관된 네트워크 구성을 제공하는 가상 스위치

4-4. 표준 스위치 구성 요소

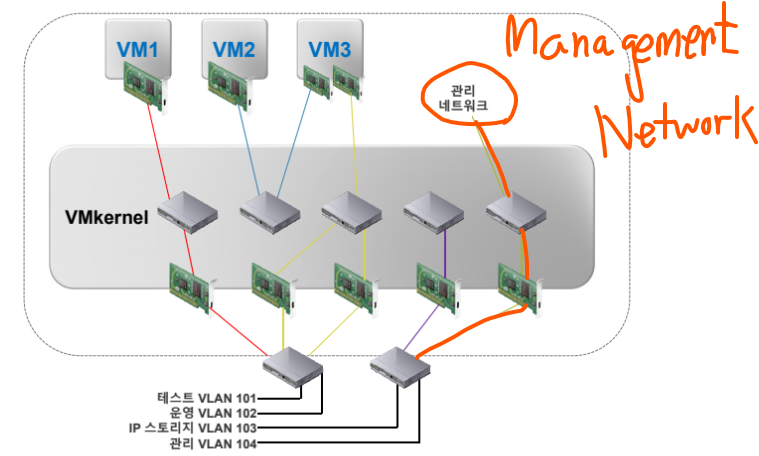

4-5. VLAN

(1) ESXi는 802.1Q VLAN Tagging을 제공한다.

* 802.1Q는 IEEE에서 정의한 표준으로, 이더넷 네트워크에서 VLAN(Virtual Local Area Network) 태깅을 위한 프로토콜이다. 이 표준은 이더넷 프레임에 VLAN 정보를 추가하여 네트워크를 논리적으로 분할할 수 있게 된다.

(2) 가상 스위치에서의 태깅은 지원되는 세 가지 정책 중 하나이다.

(3) 가상 머신의 패킷은 가상 스위치를 떠날 때 태그가 지정된다.

(4) 패킷이 가상 머신으로 복귀하면 태그가 제거된다.

(5) 성능에 대한 영향은 거의 없다.

(6) ESXi는 포트 그룹에 VLAN ID를 제공하여 VLAN 기능을 지원하고 있다.

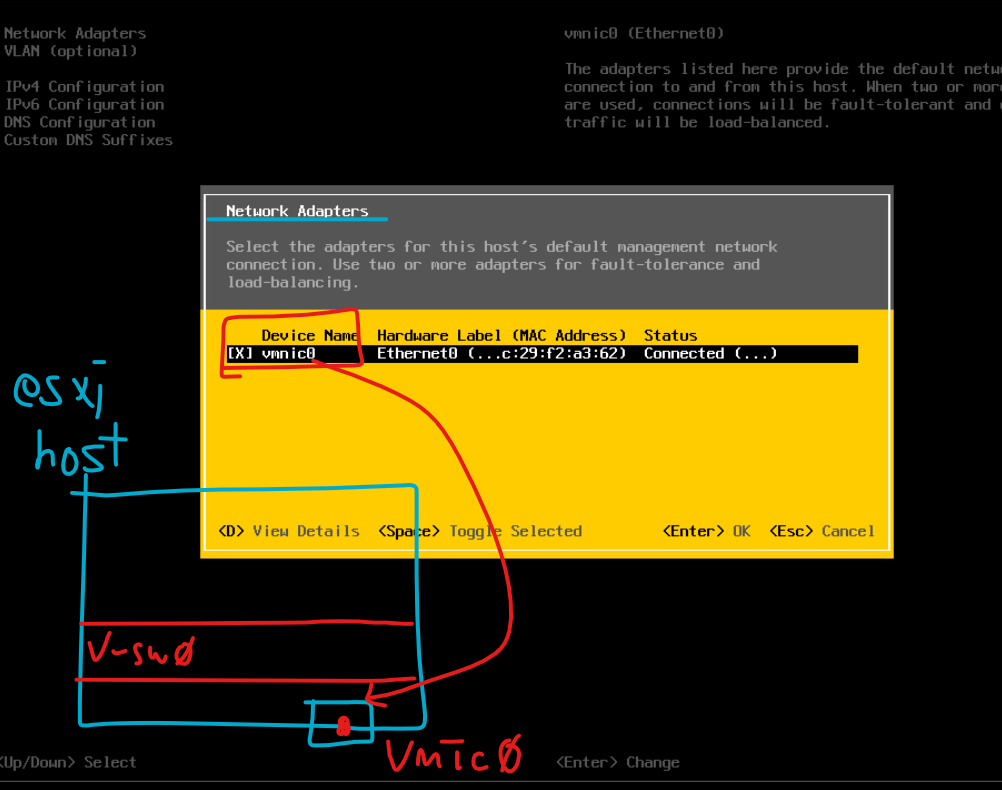

4-6. Network Adapter Management

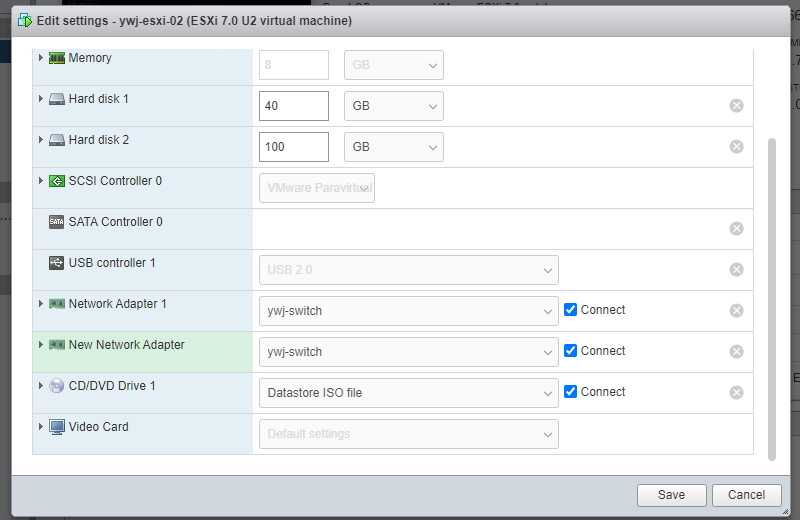

(1) 네트워크 어댑터 구성도 설정할 수 있다.

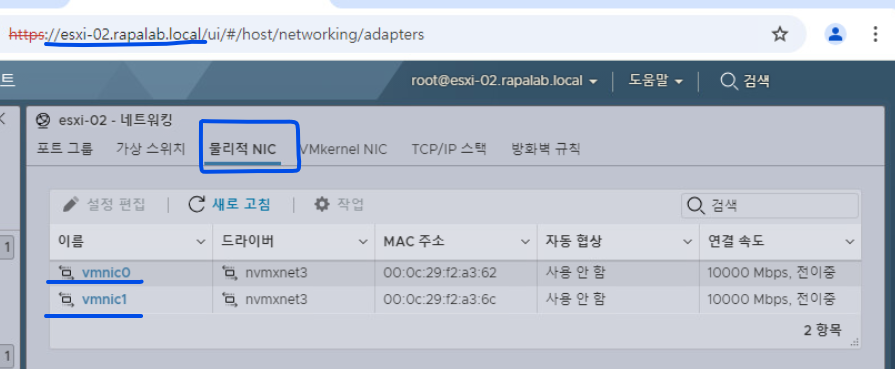

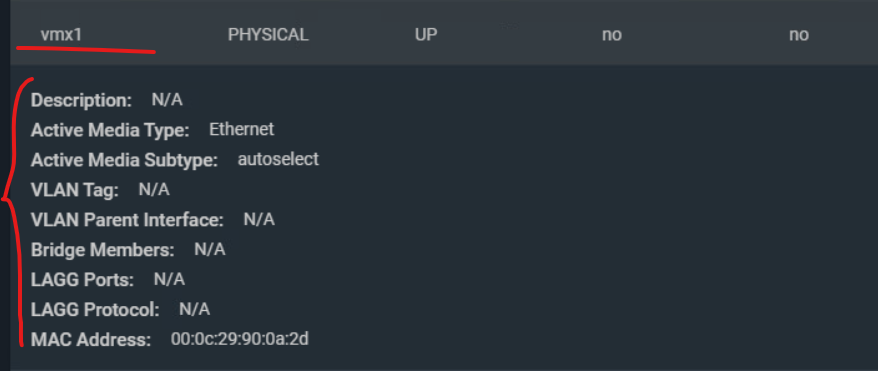

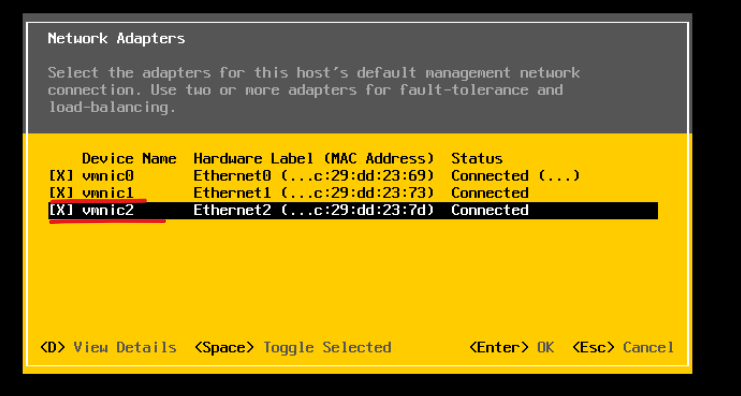

(2) 어댑터 구성 정보를 확인하기 위해 esxi-02의 네트워크 어댑터를 1개 추가한다.

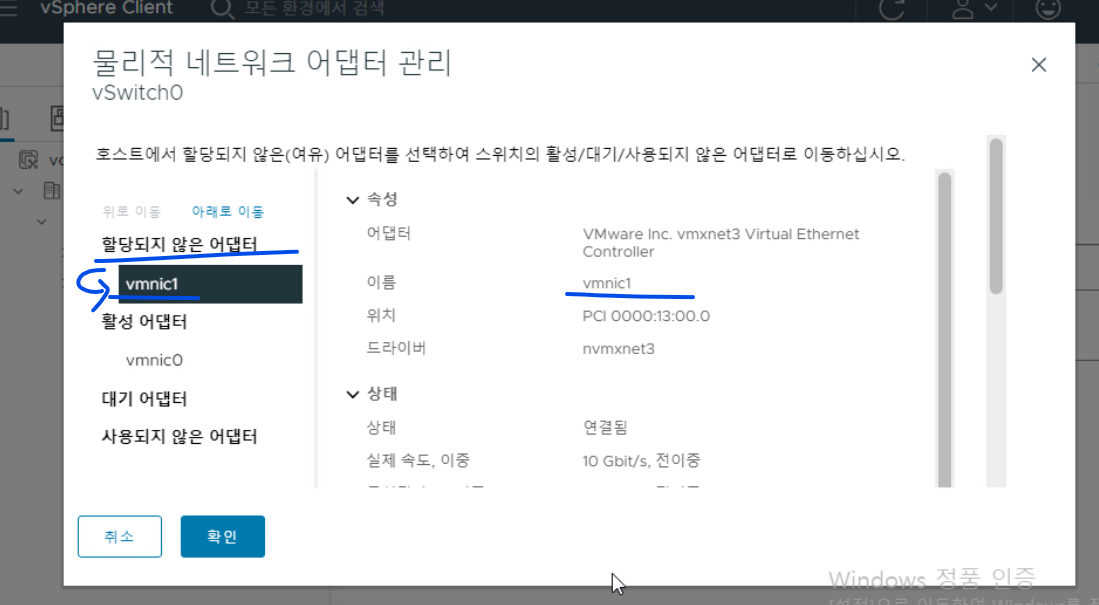

(3) 새로운 네트워크 인터페이스 어댑터가 확인된다 (VMNIC1)

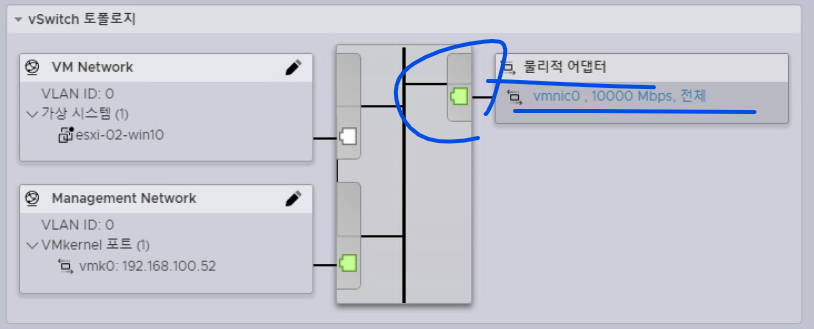

(4) vCenter Server의 ESXi-02 호스트 > 네트워크 > 가상 스위치 내역에서도 추가된 인터페이스 확인이 가능하며 현재 할당되지 않은 상태임을 나타낸다.

(5) 물리적 NIC에서 현재 모든 네트워크 어댑터 인터페이스가 확인된다.

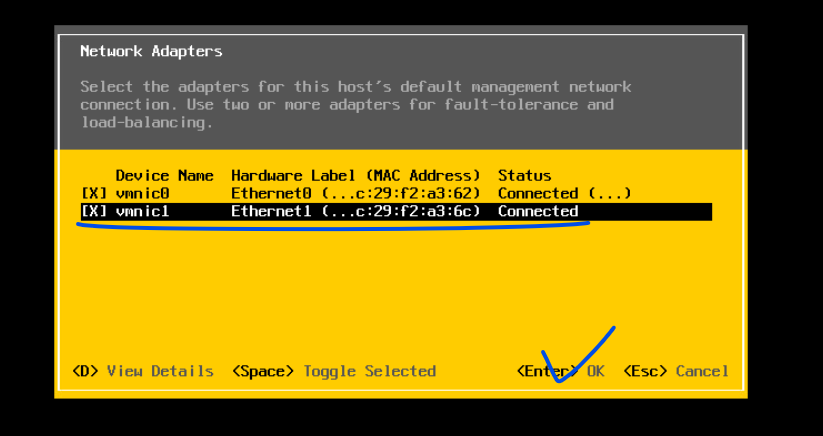

(6) 그러나 DCUI 콘솔에서 활성화를 시키지 않아서 VMNIC1 인터페이스가 보이지 않는다.

(7) DCUI에서 활성화가 가능하므로 DCUI에 접속해서 활성화를 직접 시키고 SAVE한다.

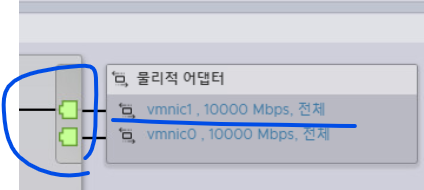

(8) ESXI 호스트에서 재확인하면 활성화된 포트가 확인된다.

(9) vCenter Server에서 접속해서 보면 활성화된 포트를 확인할 수 있다.

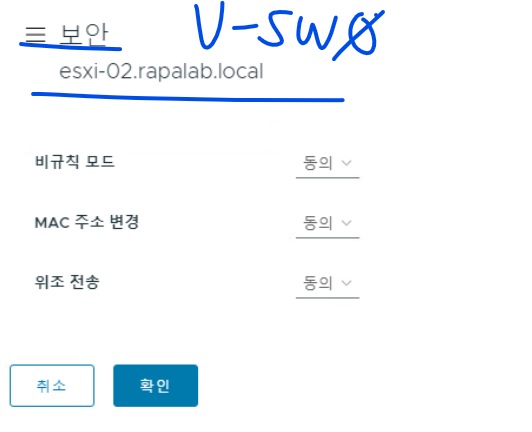

(10) 추가적으로 호스트의 가상 스위치에 대한 보안 등 기타 옵션도 모두 설정 가능하다.

4-7. 물리적 네트워크 고려 사항

(1) 네트워크 관리팀과 함께 VMware vSphere 네트워킹 요구 사항을 아래와 같이 논의할 수 있다.

(2) 물리적 스위치 수

(3) 필요한 네트워크 대역폭

(4) 802.3AD의 물리적 스위치 지원(NIC 티밍의 경우)

* 스위치에서의 "티밍(Teaming)"은 Ether-Channel의 개념이며 여러 개의 네트워크 포트를 결합하여 하나의 논리적 포트로 구성하는 기술을 의미한다. 이를 통해 네트워크의 대역폭을 증가시키고, 이중화와 부하 분산을 수행할 수 있다. 일반적으로 "링크 집합(Link Aggregation)" 또는 "포트 집합(Port Aggregation)"이라고도 불린다.

(5) 802.1Q의 물리적 스위치 지원(VLAN TRUNK의 경우)

(6) 네트워크 포트 보안

(7) CDP(Cisco Discovery Protocol)와 해당 작업 모드

- 수신, 브로드캐스트, 수신 및 브로드캐스트 사용 안함

4-8. 호스트에 대한 네트워크 추가 실습 - 새로운 가상 스위치 생성

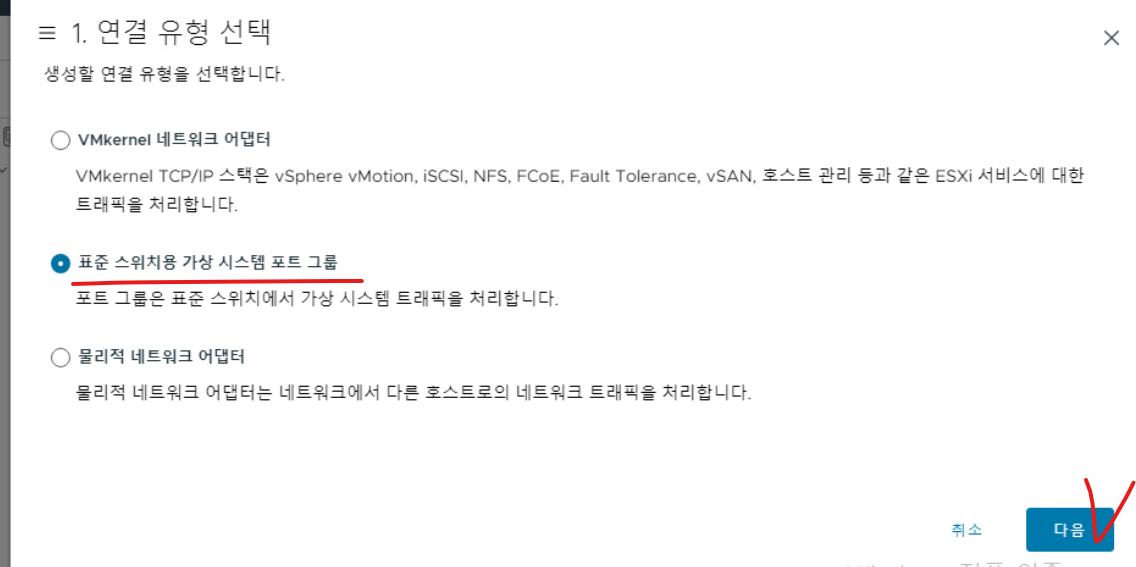

(1) ESXI-02 호스트에서 네트워크 > 가상 스위치 항목에서 네트워킹 추가를 클릭한다.

(2) 가상 스위치를 생성하므로 해당 옵션을 선택하고 다음으로 넘어간다.

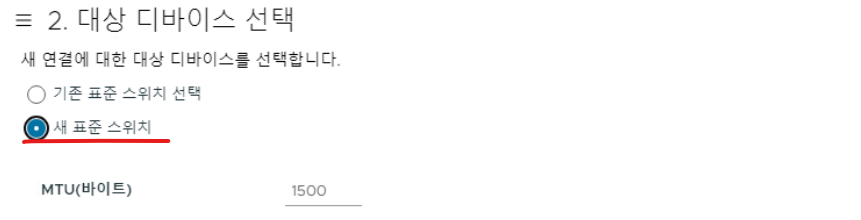

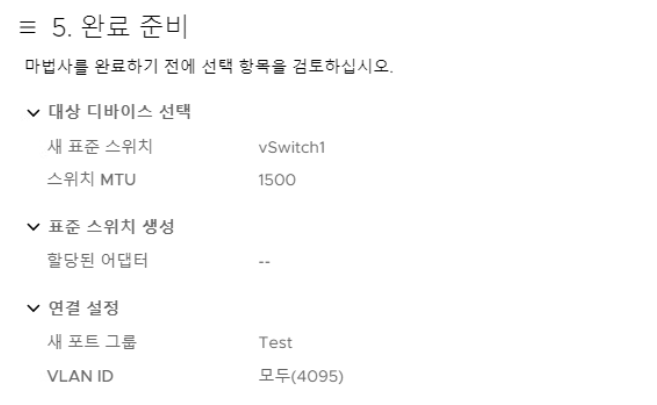

(3) 새 표준 스위치를 선택한다.

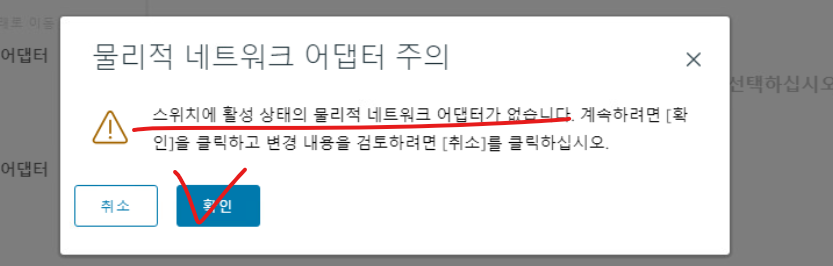

(4) 물리 네트워크 어댑터 할당의 경우 우선 다음으로 넘어간다.

(5) 물리 어댑터가 선택되지 않아 나타나는 메시지다. 확인을 클릭하고 다음으로 넘어간다.

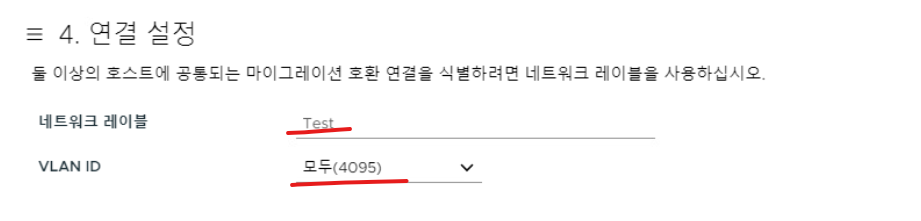

(6) 네트워크 레이블은 "Test"로 준다.

(7) 현재 포트 그룹 없이 스위치를 별도로 생성했다.

(8) 현재 생성된 vSwitch1을 보면 할당된 물리 어댑터가 보이지 않는다.

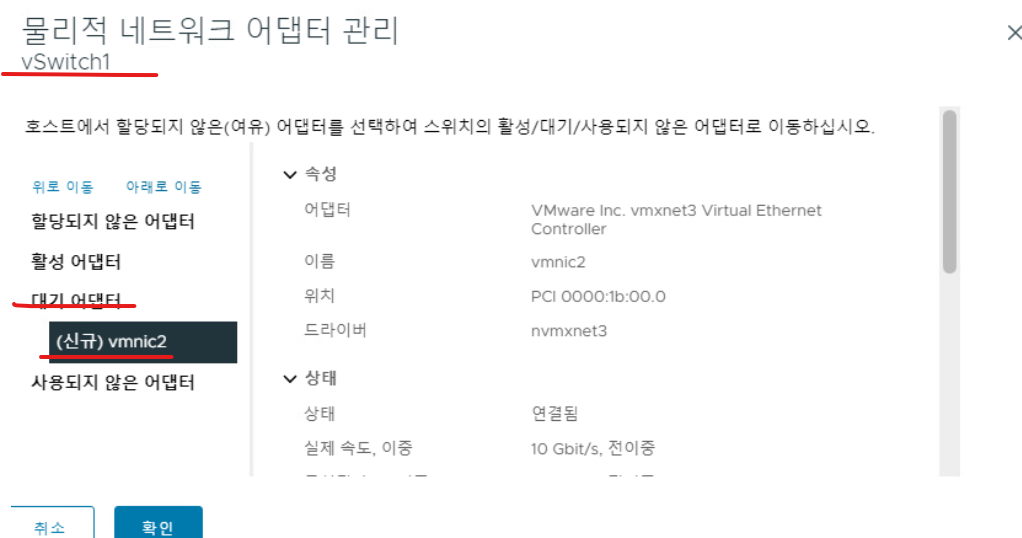

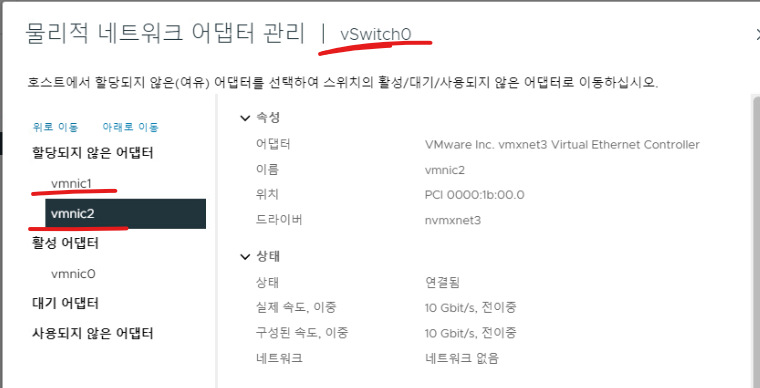

(9) 기존 vSwitch0의 물리 네트 워크 어댑터 관리에서 보면 이전에 보이지 않던 VMNIC2가 보이는데 과정에선 설명하지 않았지만 위의 방법대로 ESXi 호스트에 접속해서 ESXi-02를 기준으로 물리 어댑터를 새로 추가하고 DCUI 환경에서 해당 포트를 Enabled한 상태다. 따라서 vSwitch1에서 해당 인터페이스를 사용하기 위해 할당되지 않은 항목으로 VMNIC2를 이동시킨다.

(10) 다시 vSwitch1 물리 어댑터 관리에서 보면 VMNIC2를 확인할 수 있고, 대기 어댑터로 이동시킨다. / 필요에 따라 활성 어댑터로 이동한다.

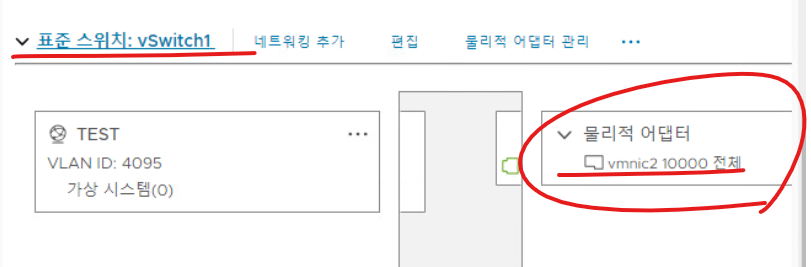

(11) vSwitch1에 VMNIC2가 확인된다.

(12) ESXi-03 호스트에 대해서도 위와 같은 작업을 수행할 수 있다.

5. VMware Virtual Networking Configuration : 표준 스위치 구성 정책

5-1. 네트워크 정책

- 세 가지 네트워크 정책이 존재한다.

(1) 보안

(2) 트래픽 조절

(3) NIC 티밍(Teaming)

- 정책은 다음 수준에서 정의된다.

(1) 표준 스위치 수준

- 표준 스위치의 모든 포트에 대한 기본 정책

(2) 포트 또는 포트 그룹 수준

- 효율적인 정책 : 이 수준에서 정의된 정책은 표준 스위치 수준에서 설정된 기본 정책을 재정의하게 된다.

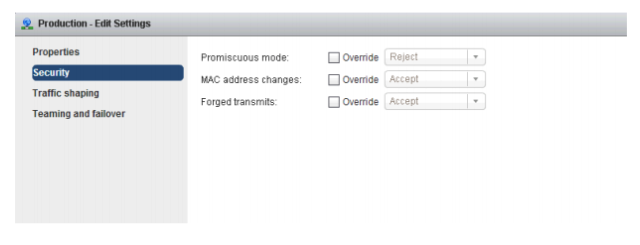

5-2. 보안 정책

(1) 관리자는 표준 스위치 및 포트 그룹에서 Layer 2계층에 대한 이더넷 보안 옵션을 구성할 수 있다.

- Promiscuous Mode, MAC Address Changes, Forged Transmits 옵션들은 네트워크 트래픽 관리 및 보안 설정과 관련된 기능을 담당하고 있다.

(2) Promiscuous mode

- 이 모드가 활성화된 가상 NIC(Virtual Network Interface Card)는 자신에게 할당된 MAC 주소와 관계없이 모든 네트워크 트래픽을 수신한다. 자신에게 할당된 MAC 주소와 상관없이 모든 네트워크 트래픽을 수용할지 결정할 수 있는 옵션이다.

(3) MAC Address Changes

- 옵션은 가상 머신이 자신의 MAC 주소를 변경할 수 있는지 여부를 제어한다.

(4) Forged Transmits

- 이 옵션은 가상 머신이 전송하는 트래픽의 MAC 주소가 해당 가상 머신에 할당된 MAC 주소와 일치하지 않아도 전송할지 결정한다. 기본적으로, 가상 머신의 MAC 주소와 일치하는 트래픽만 허용한다.

- ESXi에서는 기본적으로 Forged Transmits가 비활성화되어 있다. 이는 가상 머신이 설정된 MAC 주소 외의 MAC 주소로 패킷을 전송하는 것을 차단해 보안 수준을 높이려고 하기 때문이다.

- 이 설정을 활성화하면 가상 머신이 다른 MAC 주소로 패킷을 전송할 수 있지만 보안 위험성이 증가한다.

- 비활성화 옵션은 기본적으로 설정되어 있고, 가상 머신이 자신의 MAC 주소로만 패킷을 전송할 수 있습니다. 이를 통해 MAC 주소 스푸핑 공격을 방지할 수 있습니다.

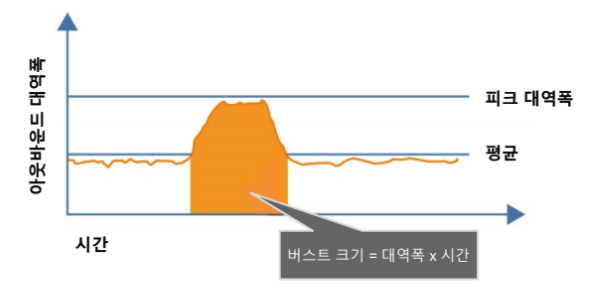

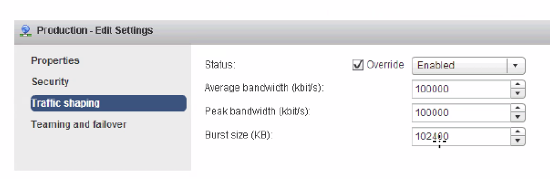

5-3. 트래픽 조절 정책과 구성

(1) 네트워크 트래픽 조절은 가상 머신의 네트워크 대역폭을 제어하는 매커니즘이다.

(2) 평균 속도, 최고 속도 및 버스트 크기를 구성할 수 있다.

(3) 트래픽 컨트롤의 경우 기본 옵션으로 사용하지 않도록 설정되어 있다.

(4) 표준 가상 스위치의 가상 NIC에 맞게 매개변수(Parameter)가 할당된다.

(5) 표준 스위치에서 트래픽 조절은 아웃바운드 트래픽만 제어하게 된다.

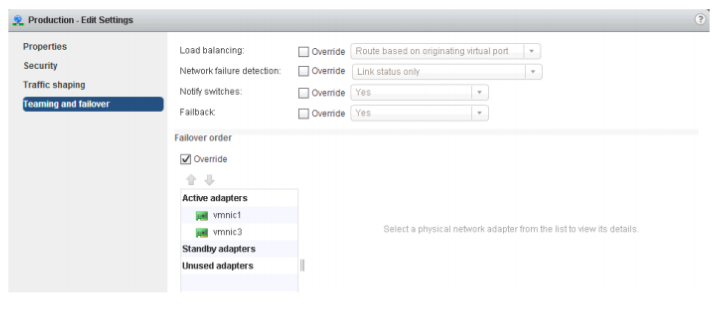

5-4. NIC 티밍 정책

(1) NIC 티밍 기술은, 여러 네트워크 인터페이스 카드(NIC)를 결합하여 하나의 논리적인 네트워크 연결로 만드는 기술을 의미한다.

(2) Load Balancing : 아웃 바운드 트래픽만 해당한다.

(3) Failback

- Failback은 장애 조치(failover) 이후, 정상 상태로 돌아온 시스템이나 네트워크 서비스를 원래의 정상 운영 환경으로 복구하는 과정을 의미한다.

(4) Network Failure Detection

- Network Failure Detection은 ESXi 호스트가 네트워크 연결의 상태를 모니터링하고 장애가 발생했을 때 이를 탐지하는 기능이다.

(5) Failover Order

- Failover Order는 네트워크 장애 발생 시 어떤 네트워크 어댑터(NIC)가 우선적으로 사용될지를 설정하는 옵션이다.

(6) Notify Swtiches

- Notify Switches는 네트워크 구성 변경 사항을 물리적 스위치에 통지하는 역할을 수행한다.

5-5. 로드 밸런싱 방법 : 시작 가상 포트 ID

(1) 시작 가상 포트 ID 로드 밸런싱은 여러 네트워크 인터페이스 카드(NIC) 또는 링크를 사용할 때, 각 링크의 고유한 ID를 할당하여 트래픽을 분산하는 방법을 의미한다.

5-6. 로드 밸런싱 방법 : Source MAC Hash

(1) Source MAC Hash 로드 밸런싱은, 패킷의 출발지 MAC 주소를 해시 함수에 적용하여 트래픽을 특정 링크로 분산하는 방법을 의미한다.

5-7. 네트워크 장애 및 감지 처리

(1) 네트워크 장애는 다음을 모니터링하는 VMKernel에서 감지된다.

- 연결 상태만 모니터링

- 연결 상태와 비콘 모니터링

(2) 스위치에서 알림을 받을 수 있는 경우

- Failover 이벤트가 발생할 때

- 새 가상 NIC가 가상 스위치에 연결될 때

(3) Failover는 구성 가능한 매개 변수를 기반으로 VMKernel에서 구현된다.

- Failback : 물리적 어댑터가 장애로부터 복구된 후 정상 작동 상태로 돌아오는 과정

- 로드 밸런싱 옵션 : 명시적으로 Failover(특정 시스템에서 장애 발생 시 서비스 유지를 위해 자동으로 다른 시스템이나 구성 요소로 전환되는 과정을 의미) 순서를 사용한다. 항상 Failover 감지 기준을 충족하는 활성 어댑터 목록에서 최우선 Uplink를 사용하게 된다.

5-8. VMBeans Networking Requirements

(1) 가상 환경 네트워크를 구축하거나 설계 시 다음과 같은 설계 사항을 고려한다.

(2) vSphere 환경에서 사용하는 VLAN에 대한 포트 그룹을 생성해야 한다.

(3) 단일 장애 지점(Single Poing of Failure)을 방지하기 위해 가상 스위치에서 NIC TEAM 구성을 사용할 수 있다.

(4) 각 트래픽 유형을 고유한 VLAN에 배치하여 애플리케이션 트래픽에서 인프라 서비스 트래픽을 분리할 수 있다.

(5) 트래픽을 세분화하면 특정 트래픽 유형에 대한 네트워크 액세스를 제한하여 성능을 향상시키고 보안을 강화할 수 있다.

(6) 사용자 환경에서 분산 스위치 이점을 조사해야 한다. 분산 스위치는 표준 스위치에 비해 추가 기능들이 존재한다.

6. Storage Configuration - Storage 개요

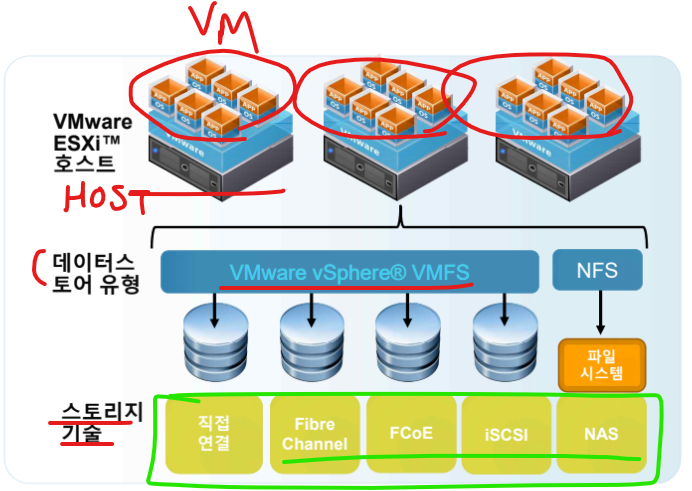

6-1. Storage 개요

- 가상화 환경에서 스토리지는 가상 머신(VM) 및 가상 환경에서 데이터를 저장하고 관리하는 시스템을 의미하고 있다.

(1) Fibre Channel

- 주로 스토리지 영역 네트워크(SAN)에서 스토리지 장치를 연결하는 데 사용되는 고속 네트워킹 기술을 의미한다.

(2) FCoE (Fibre Channel over Ethernet)

- FCoE는 Fibre Channel 프로토콜을 이더넷 네트워크에서 전송할 수 있도록 해주는 기술이다. 기존의 Fibre Channel 스토리지 네트워크를 이더넷 기반의 데이터 네트워크로 통합하여 효율성을 높인 기술이다.

(3) iSCSI (Internet Small Computer Systems Interface)

- iSCSI는 SCSI 프로토콜을 TCP/IP 네트워크를 통해 전송하는 기술로, 스토리지 장치와 서버 간의 연결을 제공한다.

(4) NAS (Network Attached Storage)

- NAS는 네트워크에 직접 연결된 스토리지 장치로, 여러 클라이언트가 파일 수준에서 데이터를 공유할 수 있도록 해주는 시스템을 말한다.

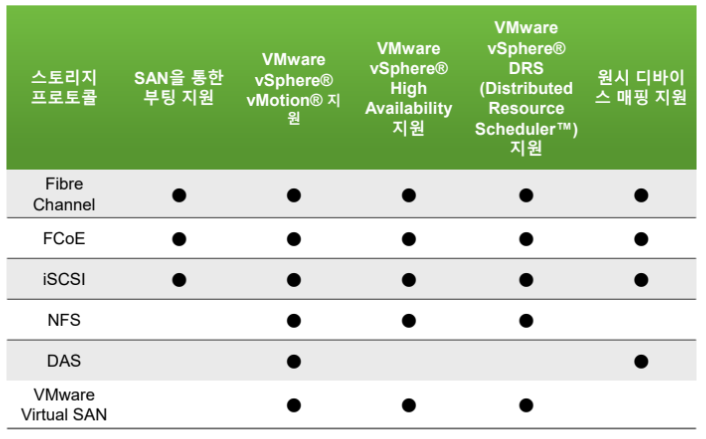

6-2. 스토리지 프로토콜의 주요 기능들

(1) SAN을 통한 부팅 지원

- SAN(스토리지 영역 네트워크)을 통한 부팅 지원은 가상 머신이나 물리적 서버가 SAN에 연결된 스토리지 장치에서 운영체제를 부팅할 수 있도록 하는 기능을 의미한다.

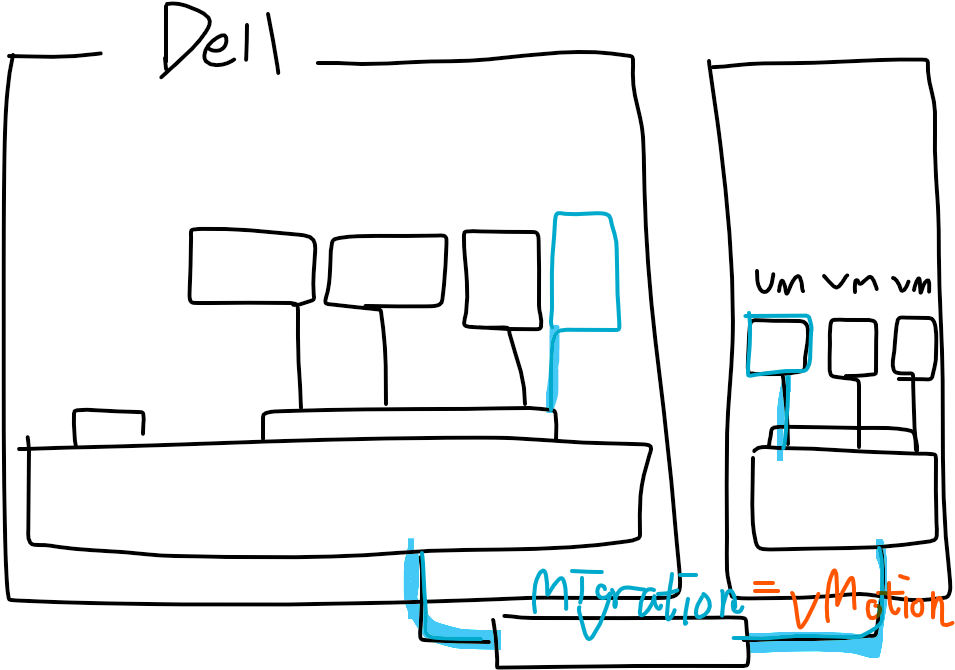

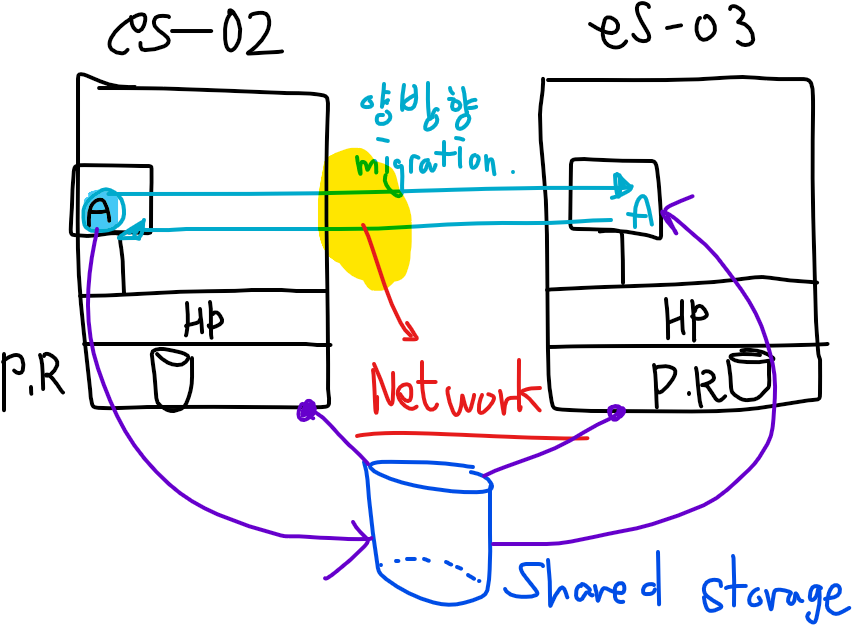

(2) VMware vSphere Motion

- VMware vSphere Motion은 가상 머신을 가동 중인 상태에서 다른 호스트로 이동할 수 있는 기능을 말한다.

- vSphere는 VM의 메모리 상태와 디스크 상태를 실시간으로 복사하여, 사용 중인 VM을 중단 없이 다른 ESXi 호스트로 이동시킬 수 있는기능을 지원하고 있다.

(3) VMware vSphere High Availability

- VMware vSphere High Availability (HA)는 가상 머신의 고가용성을 제공하는 기능이다.

- ESXi 호스트가 장애가 발생하면 HA가 자동으로 VM을 다른 호스트에서 재시작하여 가용성을 유지할 수 있다.

(4) VMware vSphere DRS(Distributed Resources Scheduler)

- VMware vSphere DRS는 가상 머신의 리소스를 자동으로 관리하고 최적화하는 기능이다.

- DRS는 클러스터 내의 여러 ESXi 호스트의 CPU와 메모리 사용량을 모니터링하고, 부하가 높은 호스트에서 VM을 자동으로 이동시키거나 리소스를 재배분하는 등의 역할을 수행한다.

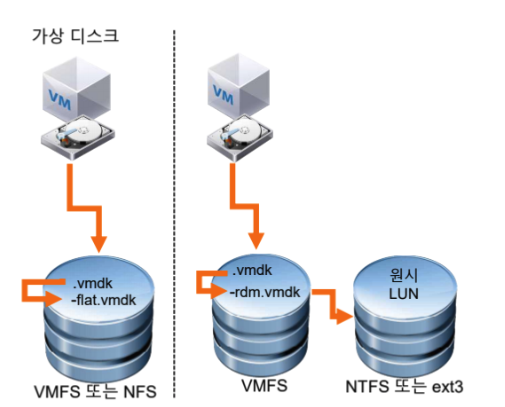

(5) 원시 디바이스 매핑 지원

- 원시 디바이스 매핑 (RDM) 지원은 가상 머신이 물리적 스토리지 장치에 직접 접근할 수 있도록 하는 기능이다.

- RDM을 사용하면 VM은 SAN의 LUN이나 물리적 디스크에 직접 매핑되어, 마치 로컬 디스크처럼 작동한다.

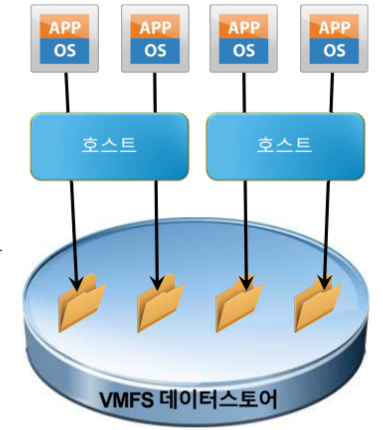

6-3. 데이터 스토어(Data Store)

(1) 데이터 스토어는 하나의 물리적 디바이스 디스크 공간을 사용하거나 여러 물리적 디바이스를 합쳐서 하나의 논리적 디스크 공간으로 사용할 수 있는 논리적 스토리지 유형을 의미한다.

(2) 데이터스토어는 물리적 디스크 환경을 각 호스트나 가상 머신들이 사용하기 위해 생성된 논리적인 디스크 공간을 의미하기도 한다.

(2) 데이터 스토어의 유형 : VMFS, NFS

(3) 데이터 스토어는 가상 머신 파일 및 템플릿 및 ISOP 이미지를 보관할 때 사용된다.

6-4. VMFS-5

(1) VMFS-5

- VMFS-5 (VMware File System 5)는 VMware의 가상화 환경에서 사용되는 파일 시스템이다.

(2) 공유 스토리지에 동시 액세스를 허용한다.

(3) 동적으로 확장 가능하다.

(4) 1MB 블록 크기를 쓰고 이 부분은 가상 디스크 파일 저장에 효율적이며 On-disk 블록 수준 잠금을 제공한다.

6-5. NFS(Network File System)

(1) NFS(Network File System)는 네트워크를 통해 파일 시스템을 공유하는 프로토콜로, 여러 서버나 가상 머신이 동일한 파일 시스템에 접근할 수 있게 된다.

(2) 파일 시스템 수준에서 네트워크에 공유된 스토리지로 TCP/IP 프로토콜을 통해 NFSv3(버전 3)을 제공한다.

6-6. 원시 디바이스 매핑

(1) 원시 디바이스 매핑은 LUN(Logical Unit Number, 스토리지 시스템에서 논리적으로 구성된 저장 장치를 식별하는 번호)에 직접 가상 머신 데이터를 저장할 수 있게 한다.

(2) 매핑 파일의 경우 원시 LUN을 가리키는 VMFS 데이터 스토어에 저장된다.

6-6. 스토리지 디바이스 네이밍 컨벤션

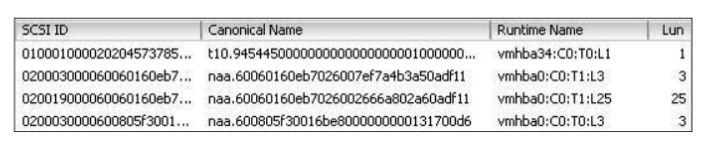

(1) 스토리지 디바이스는 여러 가지 방법으로 식별된다.

(2) SCSI ID : 고유한 SCSI 식별자

(3) 정식 이름 : NAA(Network Address Authority)는 재부팅과 상관없이 영구적으로 보장된 고유 LUN 식별자

- NAA ID 외에도 mpx 또는 T10 식별자로도 디바이스를 식별할 수 있다.

(4) 런타임 이름 : vmhbaN:C:T:L 규약을 사용한다. 해당 이름은 재부팅 시 영구적으로 유지되지 않는다.

7. iSCSI Storage Configuration

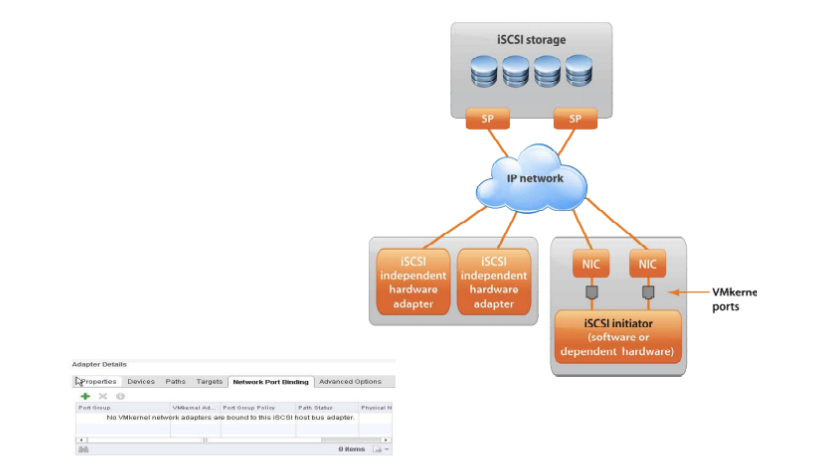

7-1. iSCSI 구성 요소

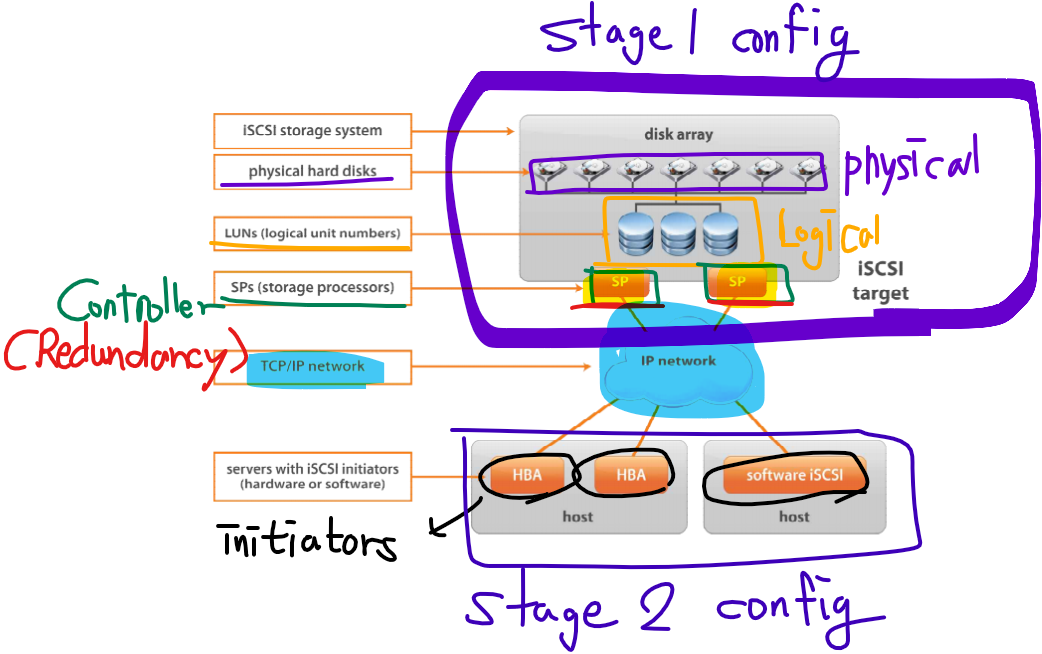

(1) iSCSI (Internet Small Computer Systems Interface) 스토리지는 IP 네트워크를 통해 SCSI 명령을 전송하여 스토리지 장치에 접근하는 방식을 말한다. iSCSI는 주로 SAN (Storage Area Network) 환경에서 사용되며, 물리적 스토리지 장치를 원격에서 연결하고 관리할 수 있게 한다.

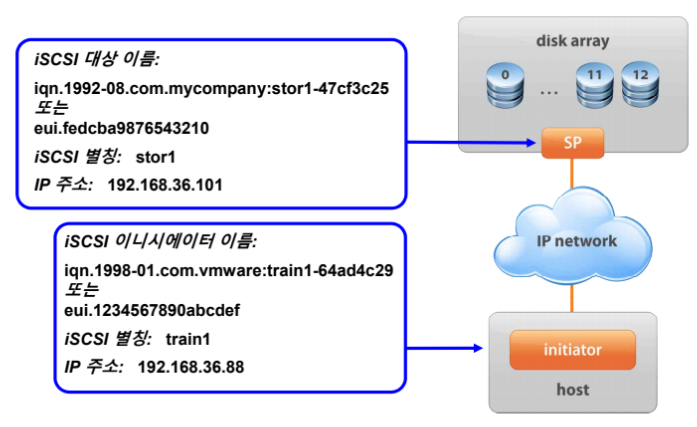

7-2. iSCSI 주소 지정

7-3. iSCSI Initiator

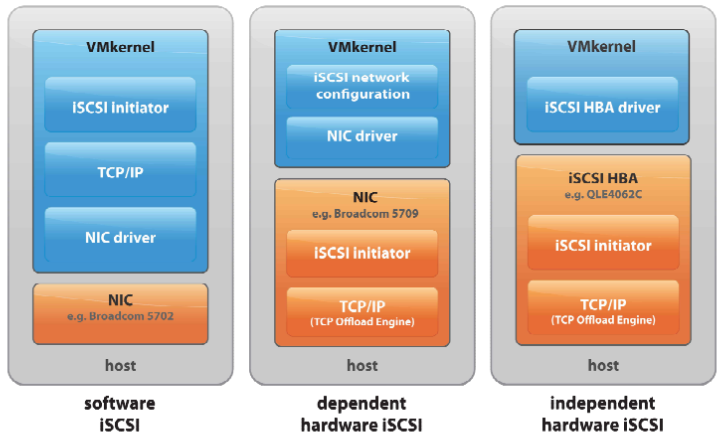

(1) iSCSI Initiator는 iSCSI 프로토콜을 사용하여 스토리지 네트워크에 연결하는 클라이언트 소프트웨어 또는 하드웨어를 의미한다.

7-4. Software iSCSI Configuration

- iSCSI 소프트웨어 Initiator를 구성하려면 아래와 같은 환경이 필요하다.

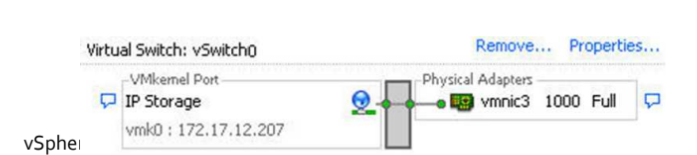

(1) IP Storage 액세스를 위한 VMKernel 포트를 구성한다.

(2) iSCSI 소프트웨어 어댑터를 사용하도록 설정한다.

(3) IQN(iSCSI의 정규화된 이름) 및 별칭을 구성한다.(필요에 따라)

(4) 정적 또는 동적 검색 주소 및 iSCSI 포트 바인딩과 같은 iSCSI 소프트웨어 어댑터 속성을 구성한다.

(5) iSCSI 보안 CHAP(Challenge Handshake Authentication Protocol)을 구성한다.

7-5. IP 스토리지의 ESXi 구성하기

(1) ESXi가 소프트웨어 iSCSI에 액세스하려면 VMKernel 포트를 생성해야 한다

- NAS/NFS 스토리지에 액세스하는데 동일한 포트가 사용될 수 있다.

(2) NAS/NFS 네트워크에서 iSCSI 네트워크를 분리(가상 스위치를 만들어서 VMKernel 포트를 통해 스토리지와 통신)한다.

- 성능 튜닝, 대역폭 관리, 보안적 측면을 고려할 때 실무에서는 분리 작업이 선행되어야 한다.

- 물리적으로 분리하는 것이 좋고, 물리적 분리가 불가능하면 VLAN을 사용한다.

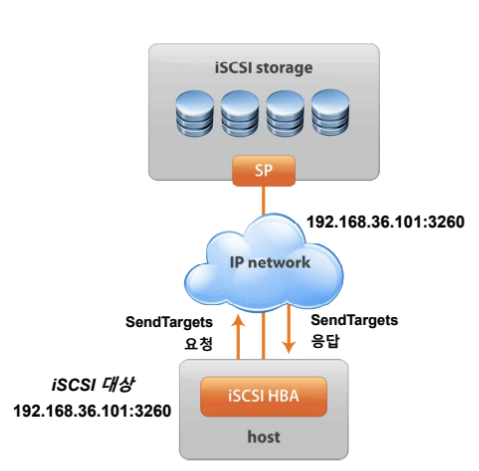

7-6. iSCSI 대상 검색 방법

(1) iSCSI 대상 검색 방법에는 두 가지 방법이 지원된다.

- 정적(Static) 검색

- 동적(SendTargets) 검색

(2) SendTargets(동적) 응답으로 IQN 및 사용 가능한 모든 IP 주소가 반환된다.

(3) IQN(Internet Qualified Name)은 iSCSI에서 사용되는 고유한 식별자를 의미한다. iSCSI Initiator와 타겟을 구별하기 위해 사용되고 주로 iSCSI 장치의 이름을 설정할 때 사용한다.

7-7. 하드웨어 iSCSI 구성 방법

(1) iSCSI 하드웨어 어댑터 설치

- 독립형 하드웨어 iSCSI 어댑터의 경우 IP 주소와 IQN이름이 제대로 구성되었는지 확인한다.

- 종속형 하드웨어 iSCSI 어댑터의 경우 포트 바인딩이 올바르게 구성되도록 어댑터와 연결된 물리적 NIC 이름을 결정한다.

(2) iSCSI 이름을 수정하고 iSCSI 별칭을 구성한다.

(3) iSCSI 대상 주소를 구성한다.

(4) iSCSI 보안(CHAP)을 구성한다.

7-8. iSCSI 스토리지를 사용해서 다중 경로 지정

(1) 하드웨어 iSCSI

- 두 개 이상의 하드웨어 iSCSI 어댑터를 사용한다.

(2) 소프트웨어 또는 종속형 하드웨어 iSCSI

- 여러 개의 NIC를 사용한다.

- 각 NIC를 개별 VMKernel 포트에 연결한다.

- VMKernel 포트를 iSCSI 이니시에이터(Initiator)와 연결한다.

(3) iSCSI 어댑터의 Adapter Details 창에서 포트 바인딩을 구성한다.

8. iSCSI Configuration LAB

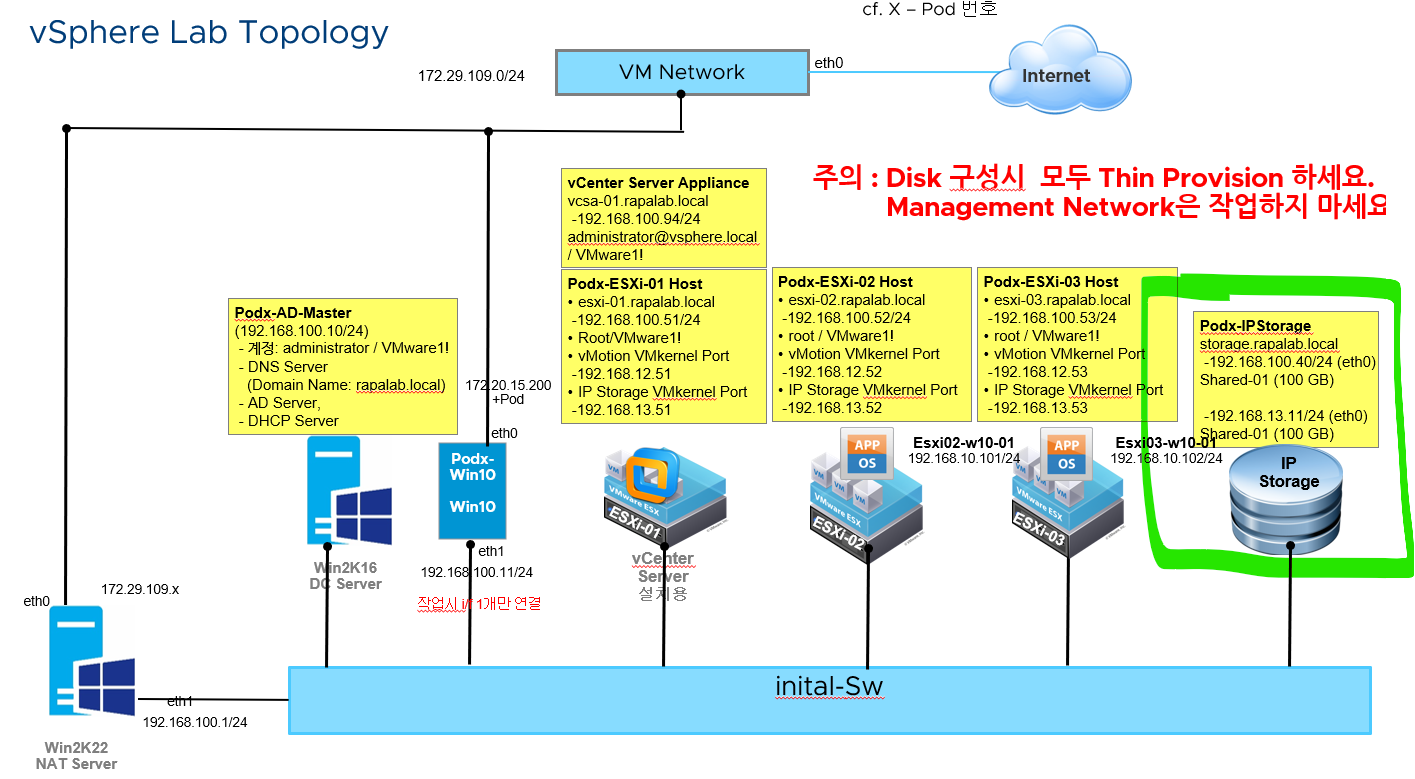

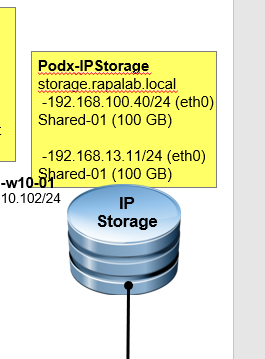

8-1. IP 스토리지를 위한 가상 머신 구성 (토폴로지 확인)

(1) 실습 토폴로지 확인

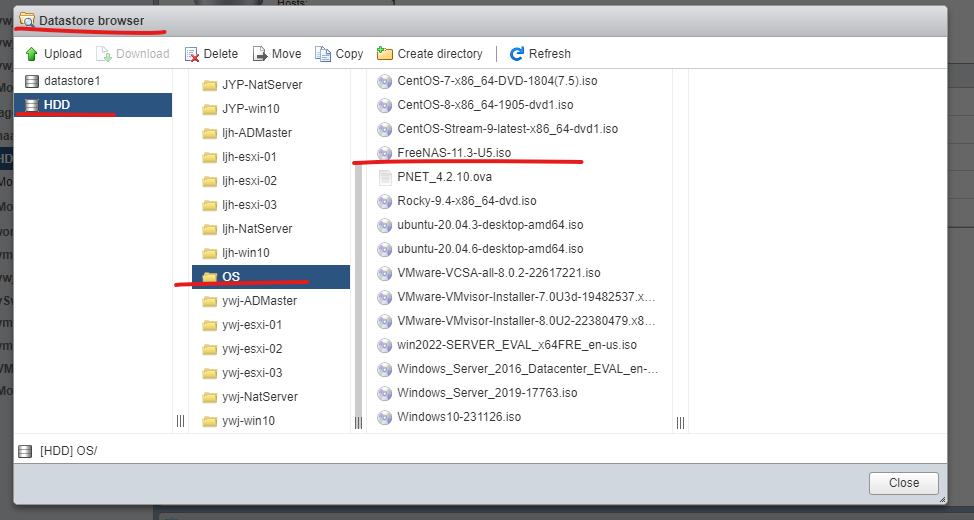

(2) IP 스토리지 구성을 위해 DELL 서버 데이터스토어에 있는 해당 파일을 사용한다.

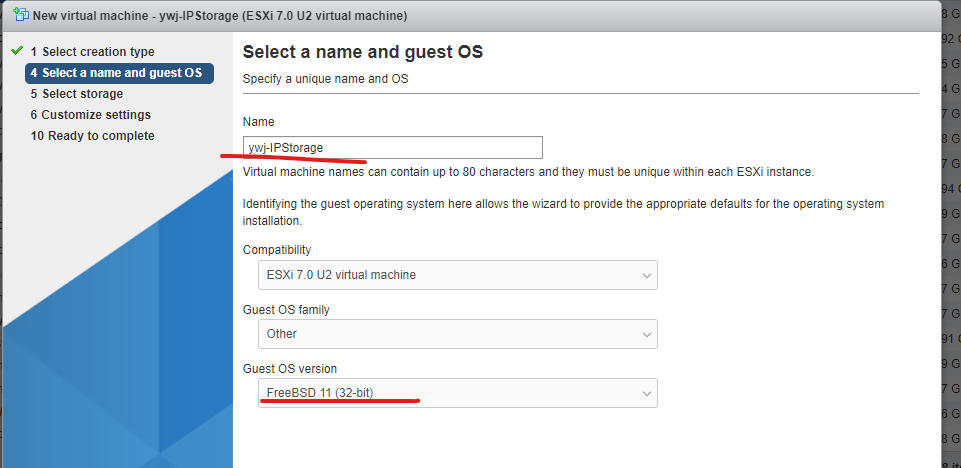

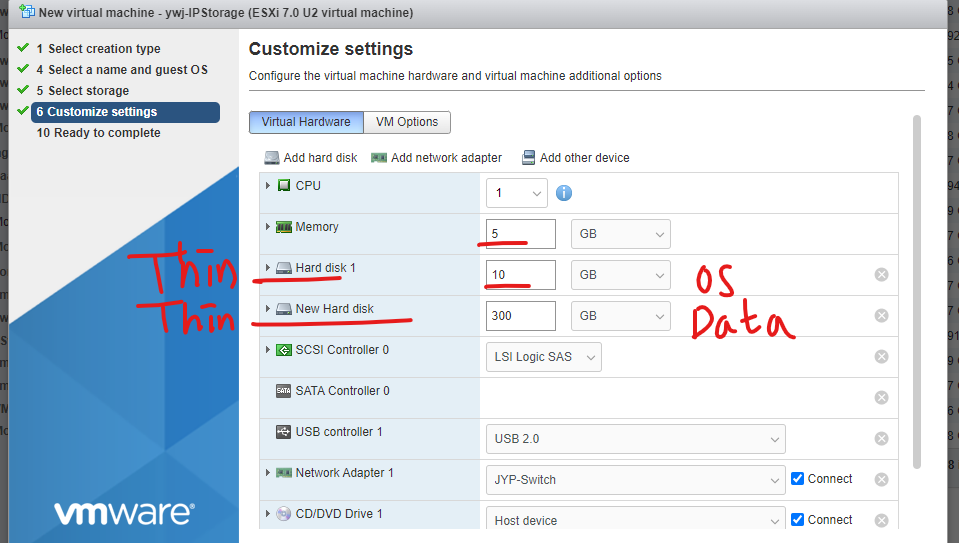

(3) 가상 머신 이름을 지정하고 OS 버전은 FreeBSD를 선택한다.

(4) OS를 위한 공간과 데이터 저장을 위한 디스크 공간을 2개 할당해 준다.

(5) 가상 머신을 시작하면 위와 같이 파일을 읽어들이면서 설치 관리자가 나타난다.

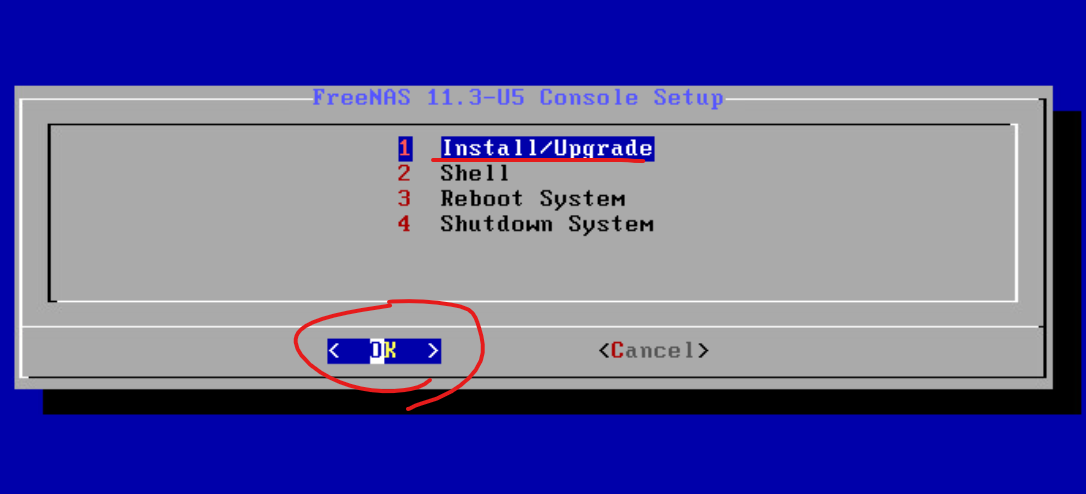

(6) 설치 관리자에서 1번 항목을 선택해서 설치를 진행한다.

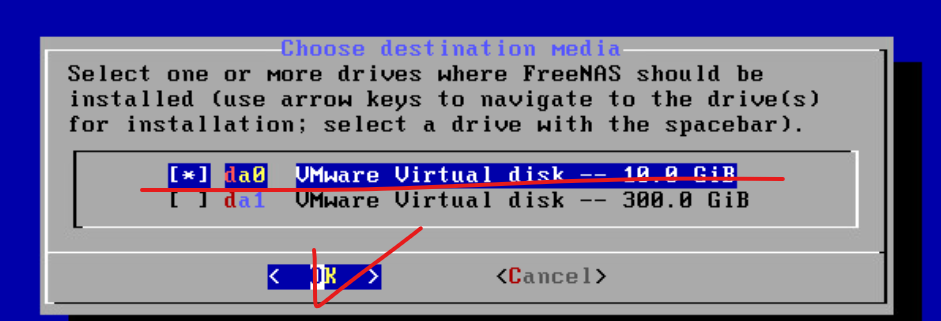

(7) 가상 머신 설정 과정에서 추가한 10GB 0번 디스크 볼륨을 선택한다.(OS 정보가 설치됨)

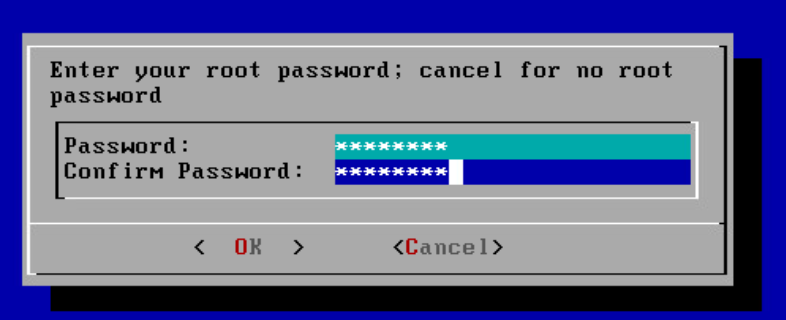

(8) 루트 관리자 계정명 / 접속 패스워드를 입력한다.

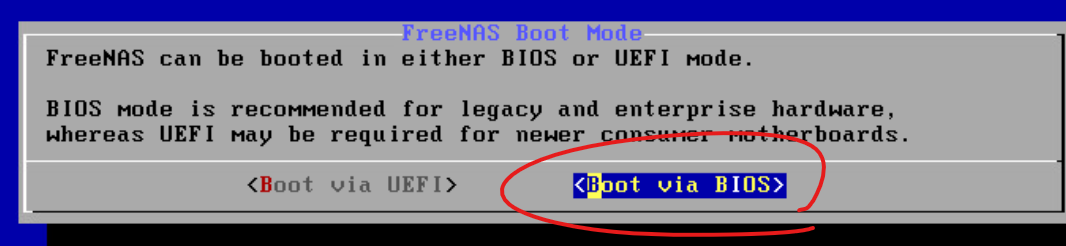

(9) 부트 모드의 경우 Boot via BIOS를 선택한다.

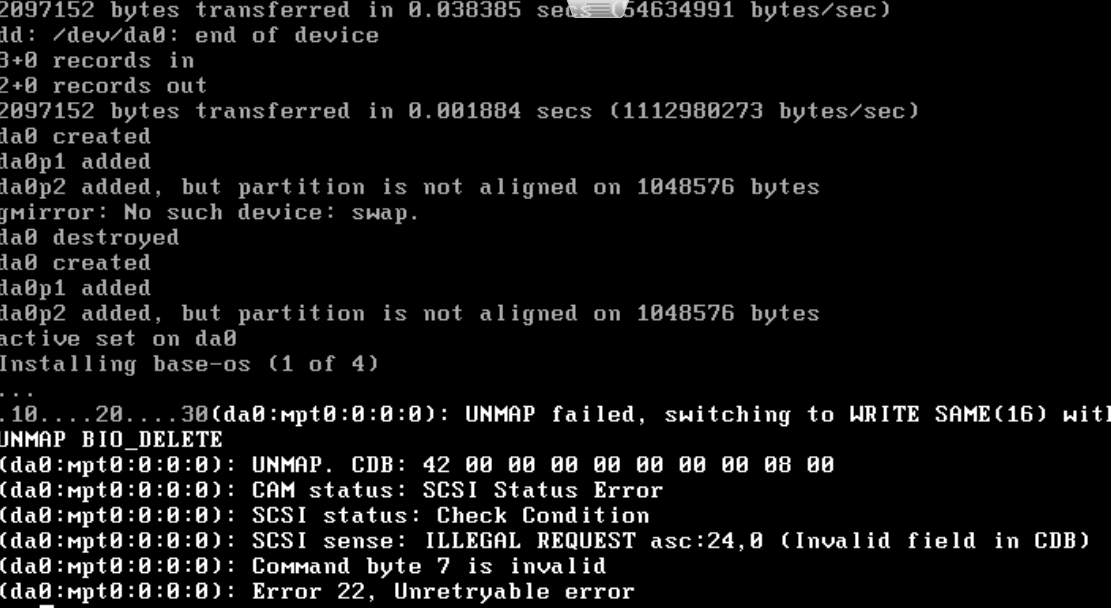

(10) 설치가 진행되는 과정인데 잠시 시간이 소요된다.

(11) 설치가 완료된다면 설치 관리자가 다시 한 번 나타나는데, 시스템을 재부팅한다.

8-2. 재부팅 완료 이후 작업

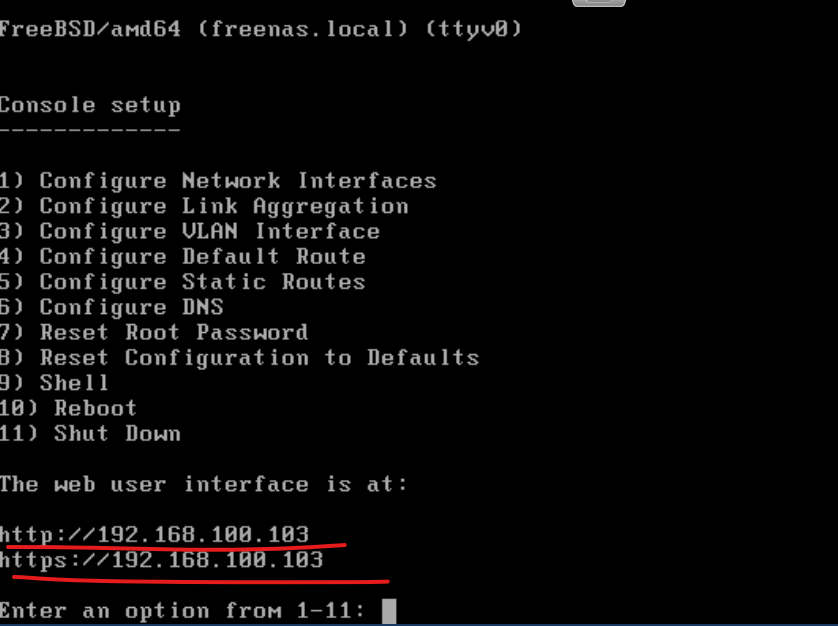

(1) 재부팅 완료 후 콘솔에 접속되는데 현재 IP 주소가 위와 같이 DHCP에 의해 동적으로 잡혀 있는 상태다.

(2) 실습 토폴로지를 참고하면 구성 정보는 위와 같다.

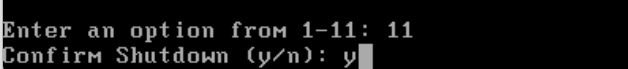

(3) 11번 옵션을 주고 shutdown을 진행한다.

(4) 새로운 인터페이스 할당을 위해 위와 같이 ESXi 호스트에서 네트워크 어댑터를 추가한 후 재부팅한다.

- 이 작업을 통해 2개의 IP 주소를 받아오게 된다.

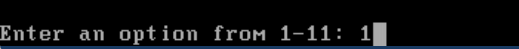

(5) 1번 옵션 선택 후 인터페이스를 선택하고 IP 주소를 정적으로 설정하는 과정이다. (vmx0 인터페이스에 대해 설정)

(6) 토폴로지에 맞게 위와 같이 설정한다.

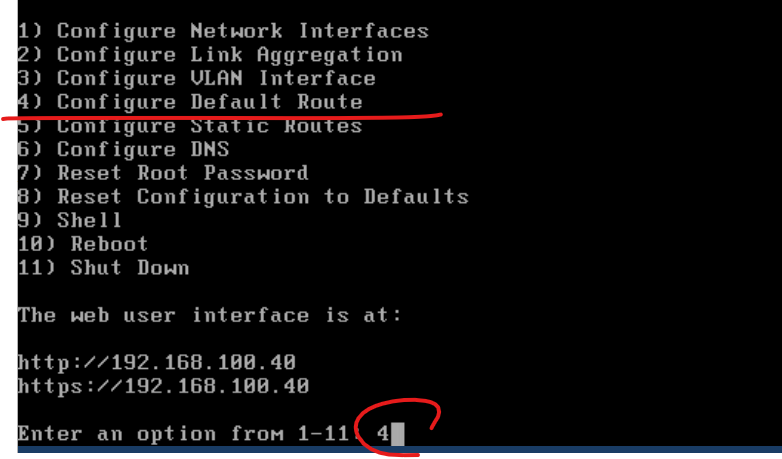

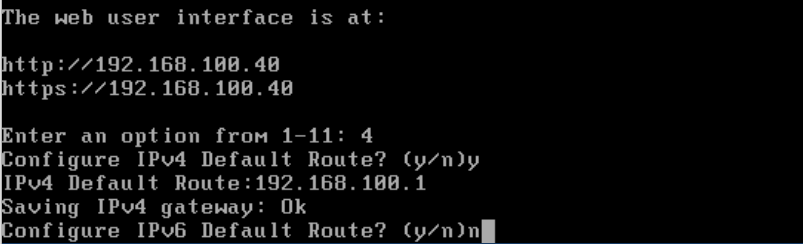

(7) 4번 옵션을 주면 Default Routing 설정이 가능하다.

(8) IPv4 Route : Y / Default Route Input : 192.168.100.1 / Configure IPv6 Default Route : N

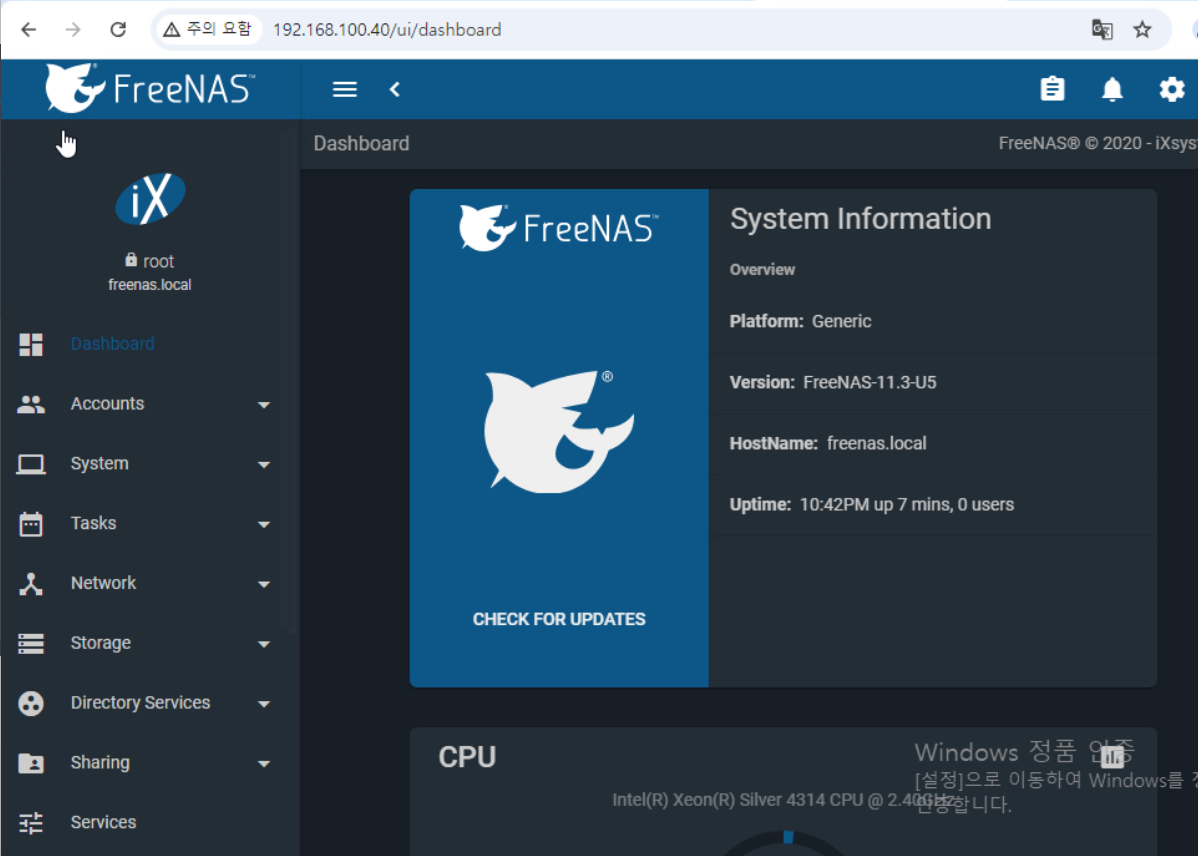

8-3. Windows 10 환경으로 접속 / ping 테스트 / 192.168.100.40으로 접속되는지 확인

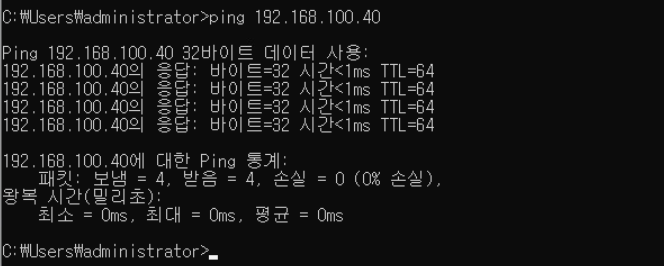

(1) Windows 10 Command Prompt에서 IP Storage 서버로 ping이 수행되는지 확인한다.

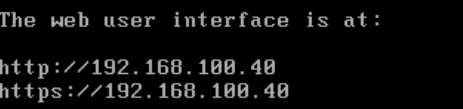

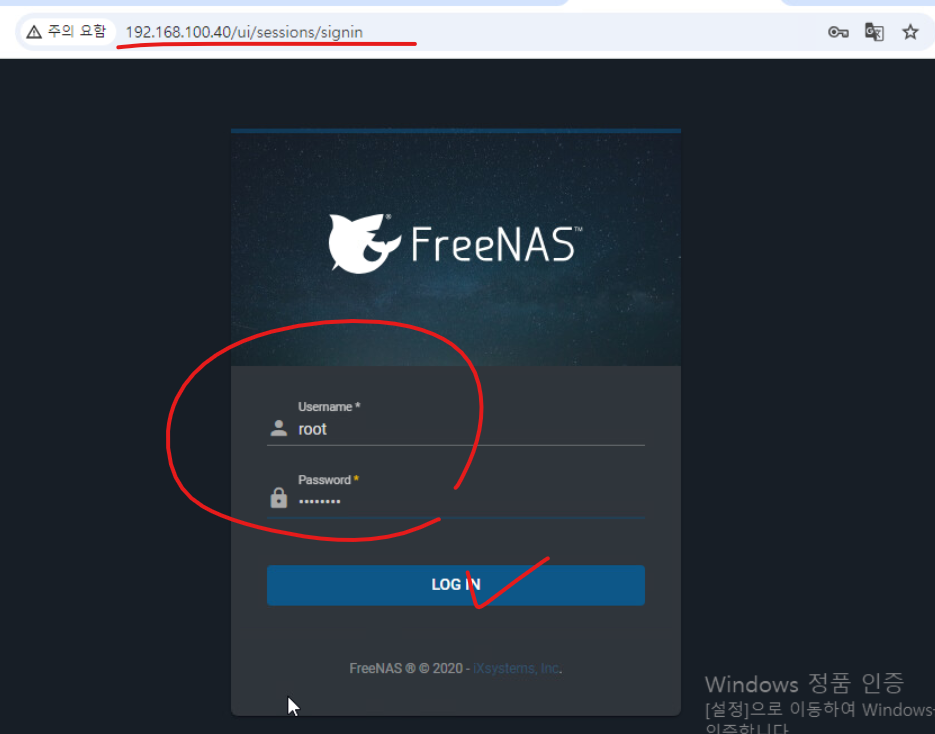

(2) 웹 브라우저에서 IP Storage의 주소로 접속한다.

(3) 위와 같이 Dashboard가 확인된다면 정상적으로 접속된 것이다.

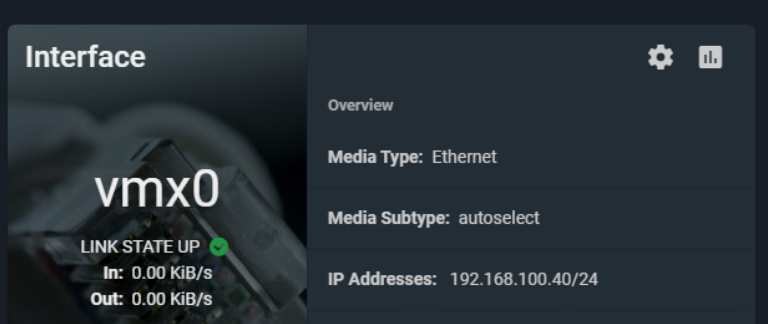

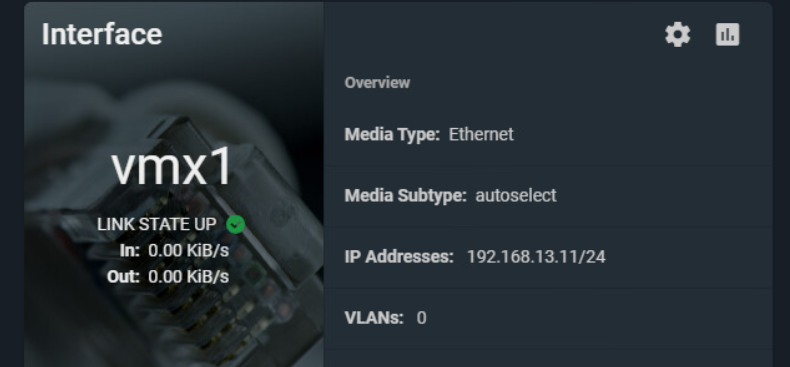

(4) 이전 콘솔 환경에서 설정한 vmx0 인터페이스의 IP 주소가 확인된다.

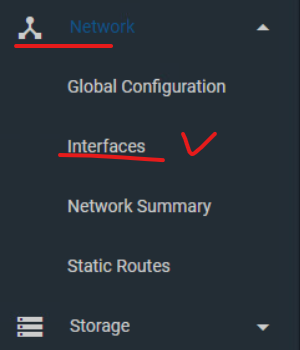

(5) 좌측의 네트워크 메뉴에서 인터페이스로 접속한다.

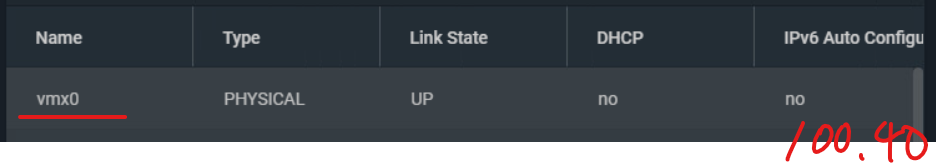

(6) vmx0 인터페이스 우측을 보면 이전에 할당된 IP 주소를 확인해 볼 수 있다.

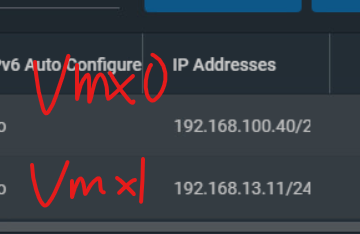

(7) 데이터 통신을 위한 VMX1 포트도 IP 주소 할당이 필요하다. 하단에 EDIT를 눌러서 주소를 할당해 준다.

(8) vmx1 인터페이스에 대해 토폴로지 구성을 참고해서 주소를 입력하고 MTU는 9000으로 입력한다.

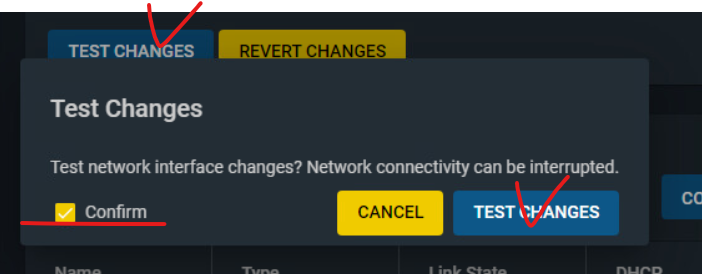

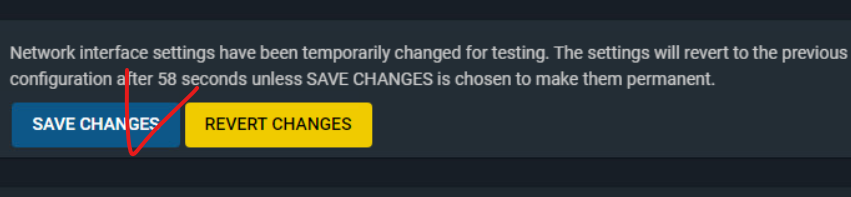

(9) Apply를 눌러 적용한 후 Test Changes를 진행한다.

(10) Test Changes 이후 모든 정보를 저장하기 위해 Save Changes를 진행한다.

(11) VMX0, VMX1 인터페이스에 대한 주소를 확인할 수 있다.

(12) 인터페이스 항목에서도 확인 가능하다.

8-4. Storage : Pool 생성 작업 & Pool 내부 볼륨 생성 작업

(풀 생성 : 물리적인 디스크 공간을 논리적으로 분할하여 특정한 풀을 생성하는 작업)

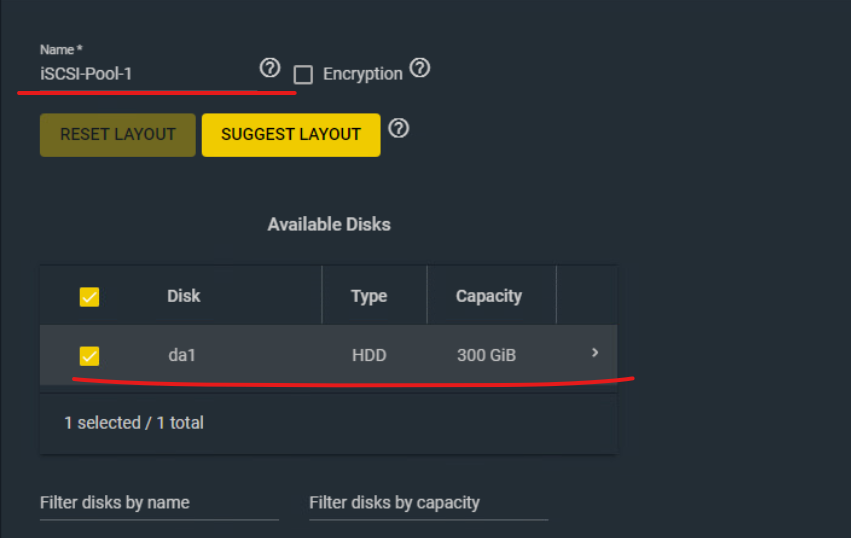

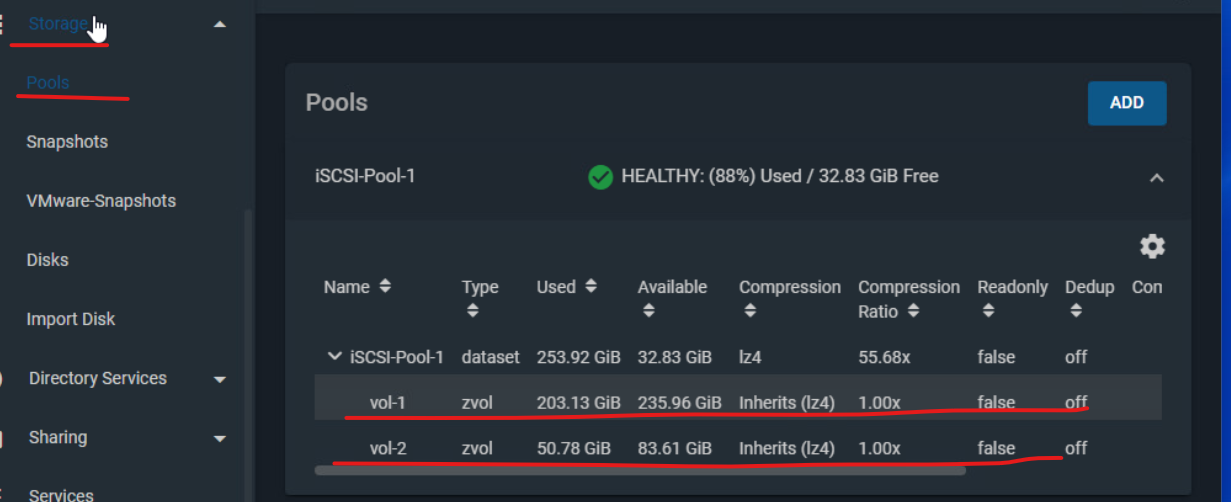

(1) Storage 항목에서 Pools > ADD를 클릭해서 풀을 생성한다.

(2) Pool 이름의 경우 위와 같이 설정하고 가상 머신 설정 과정에서 할당한 하드 디스크를 체크한다.

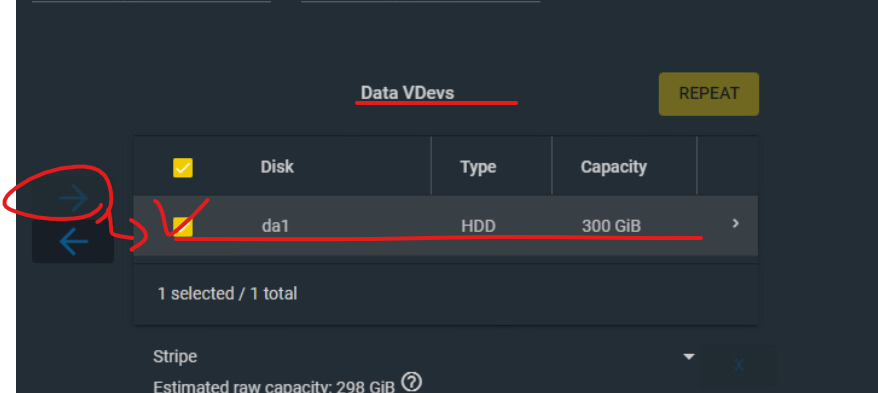

(3) 이후 Data VDevs 항목에서 우측 화살표를 눌러서 이전에 선택한 디스크를 VDevs로 이동시키고 Stripe 방식을 선택한다.

(4) CREATE를 누르면 경고창이 한 번 나타나는데 풀을 생성한다.

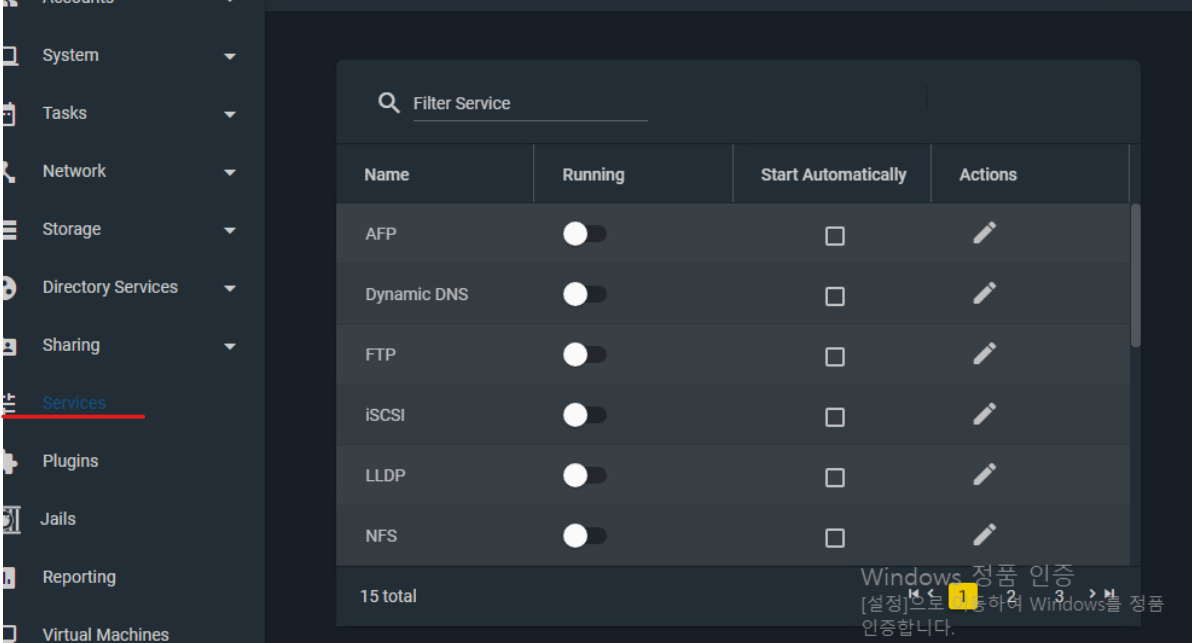

(5) 우측 메뉴 중 서비스로 접속한다.

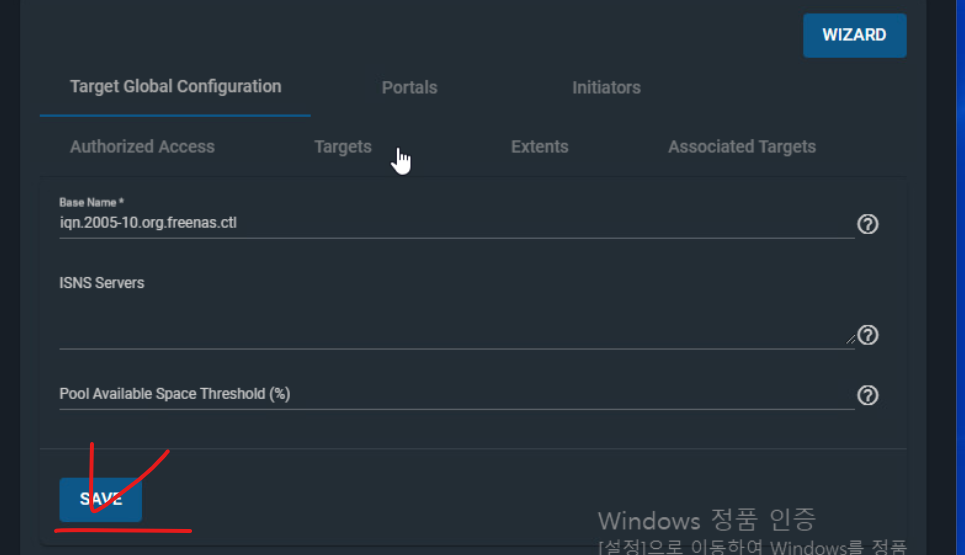

(7) iSCSI 항목에서 Running을 활성화하고 Start Automatically 옵션까지 활성화한 뒤 Actions를 클릭한다.

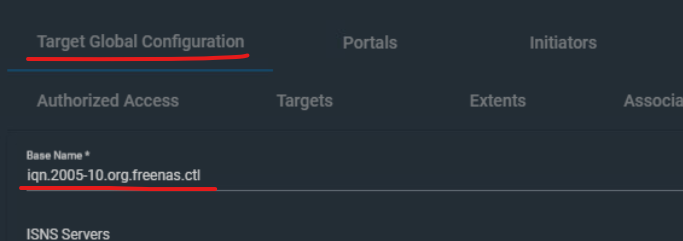

(8) 해당 과정에서 설정해줄 부분은 없고 베이스 네임만 확인한 뒤 Save 한다.

(9) 상단의 wizard를 누르면 Block Device를 생성할 수 있는 Wizard가 나타난다.

- 블록 디바이스는 데이터를 블록 단위로 저장하고 관리하는 저장 장치를 의미한다.

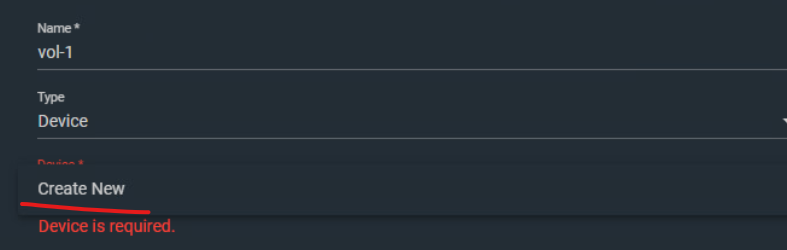

(10) 이름은 "vol-1", Device의 경우 새로 생성하기를 클릭한다.

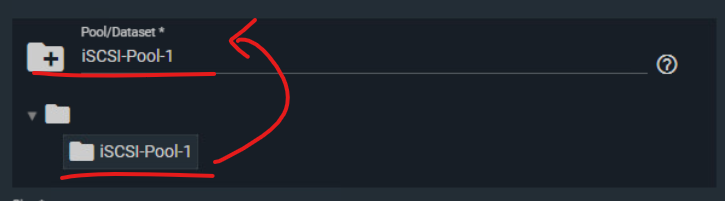

(11) iSCSI-Pool-1 디렉터리를 선택한다.

(12) 1번 볼륨의 경우 200GB 용량을 줄 것이므로 NEXT를 누른다.

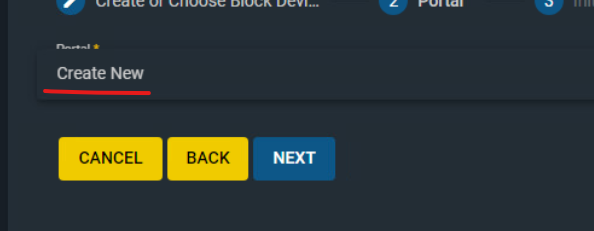

(13) 실제 통신을 위한 Portal을 만들어줘야 하는데 현재 생성된 포탈이 없으므로 하나 생성해 준다.

(14) 실제로 스토리지 마이그레이션 과정에서 데이터가 오고 가는 통로 역할을 하는 대역은 192.168.13.11이므로 주소를 위와 같이 지정해 준다.

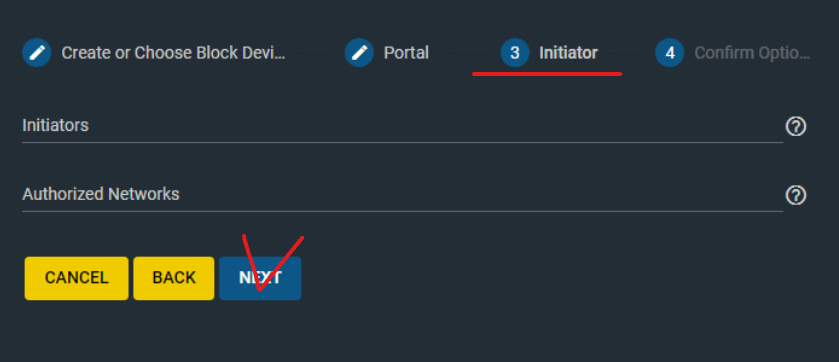

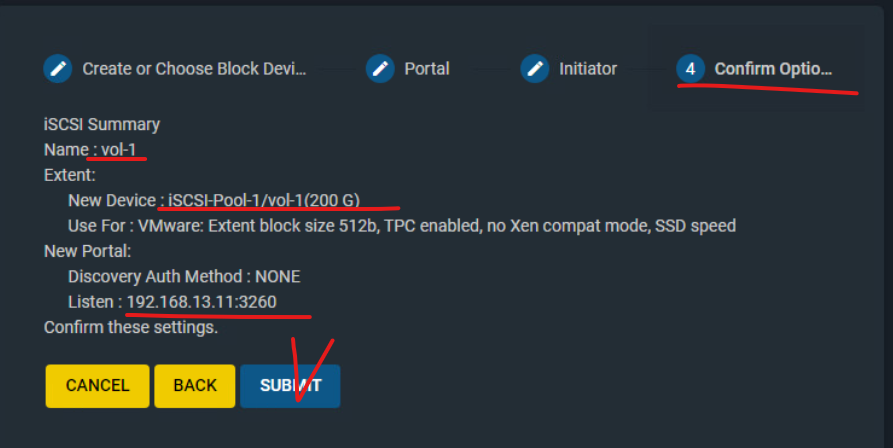

(14) Initiators 항목은 그냥 넘어간다.

(15) SUBMIT 버튼을 눌러 풀을 이렇게 첫 번째 풀을 생성했다면 두 번째 풀도 위와 같은 방법으로 생성한다.

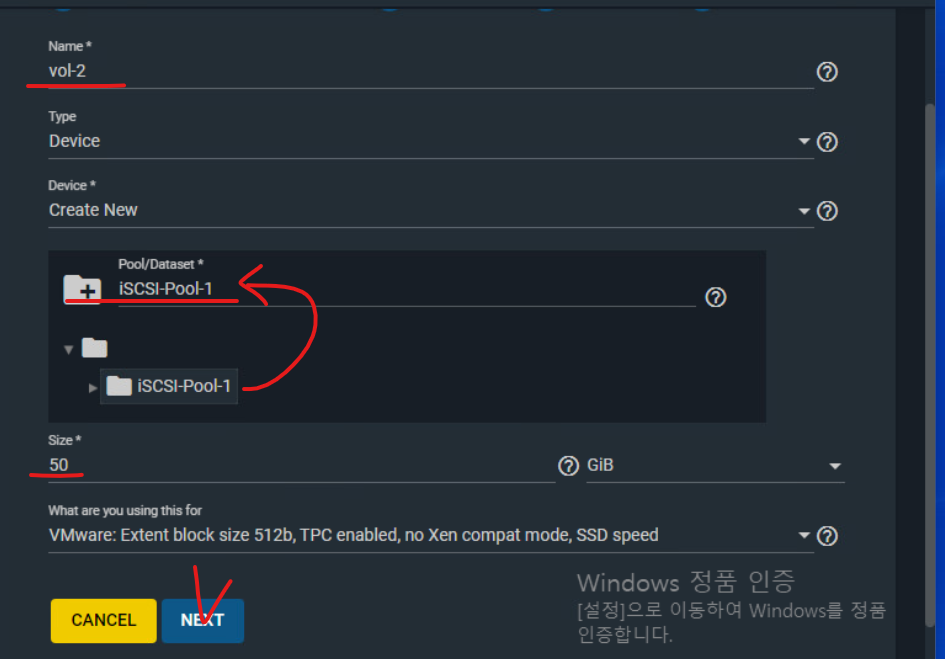

(16) vol-2을 생성한다. / 용량은 50GB으로 할당한다.

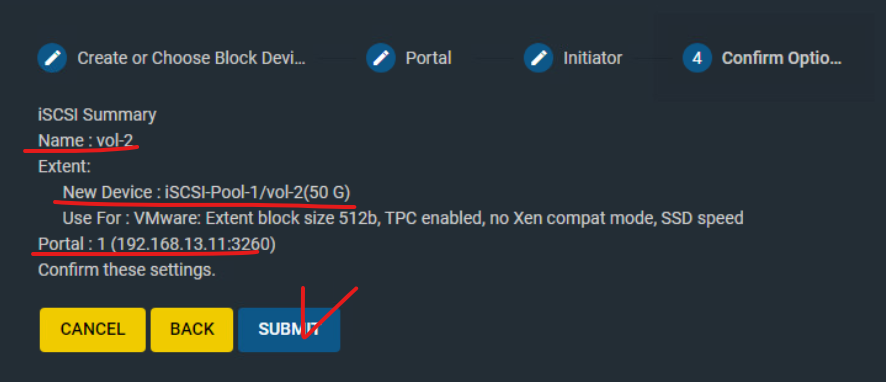

(17) 데이터 통신을 위한 포탈을 생성했으므로 vol-2에도 이전에 생성한 포탈을 적용한다.

(18) 생성 정보를 확인하고 SUBMIT을 눌러 생성을 완료한다.

(19) iSCSI Actions 탭에서 SAVE까지 눌러서 전체 내용을 저장한다.

(20) Storage Pools 항목에서 방금 생성한 vol-1, vol-2 리스트가 확인된다면 정상적으로 생성된 것이다.

(21) 대시보드에서 생성한 Pool 항목이 확인된다.

8-5. vCenter Server로 접속 후 작업 : 기존 vSwitch1 제거 & VMKernel 포트를 위한 가상 스위치 추가

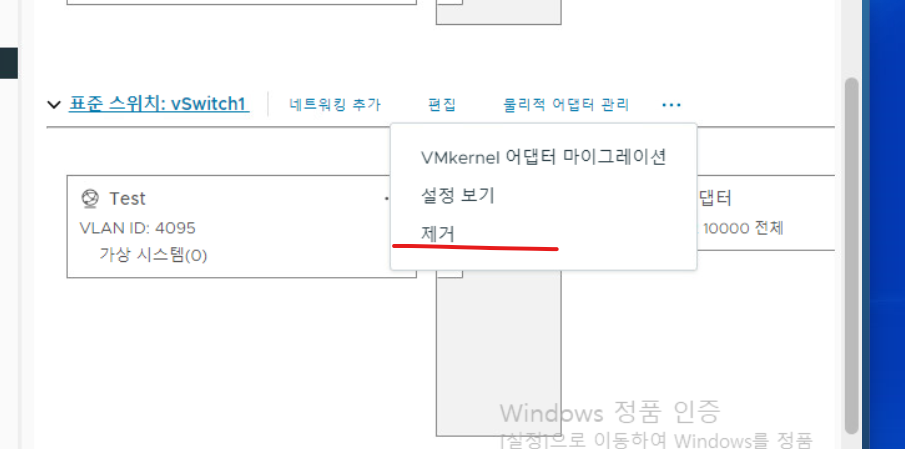

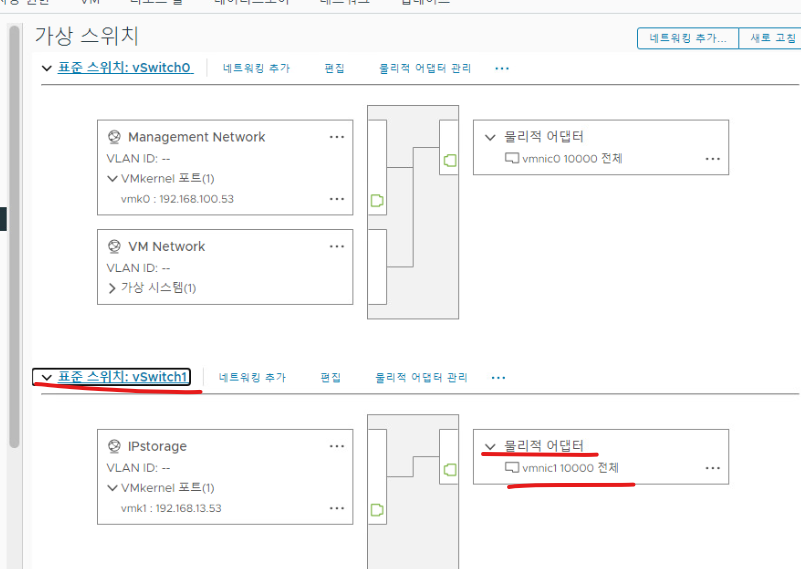

(1) 스토리지 통신을 위해 생성한 스위치를 삭제하고 새로운 가상 스위치를 할당하는 작업을 해주어야 하는 상황.

- 삭제를 진행한다

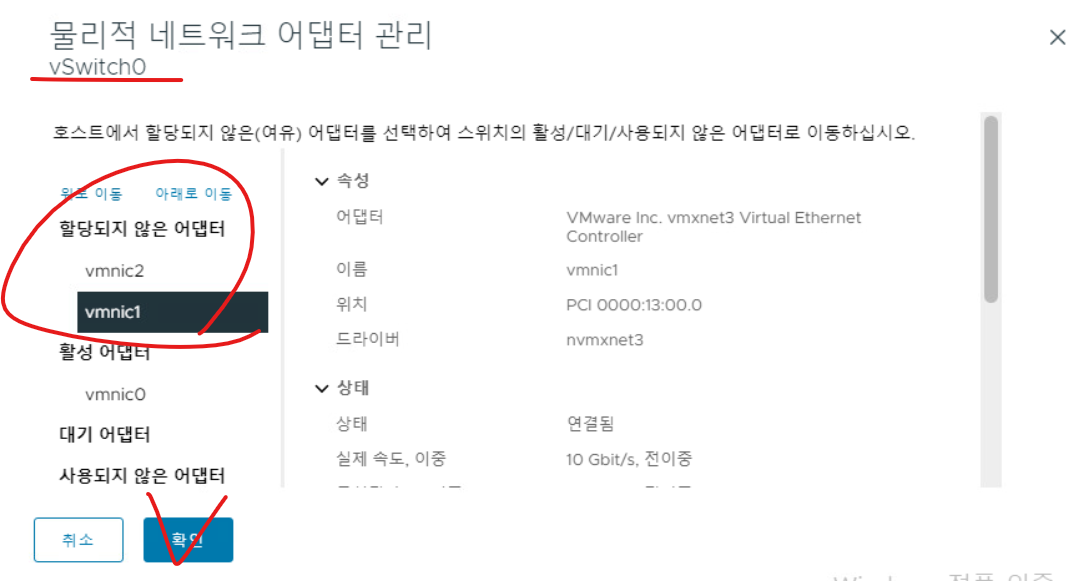

(2) vSwitch1 가상 스위치를 날리게 되면, 해당 스위치에 할당되어 있던 VMNIC2 포트도 함께 풀린다. 그 부분까지 작업하고 vSwitch0을 기준으로 나머지 VMNIC1, 2 인터페이스를 모두 할당되지 않은 항목으로 이동시킨다.

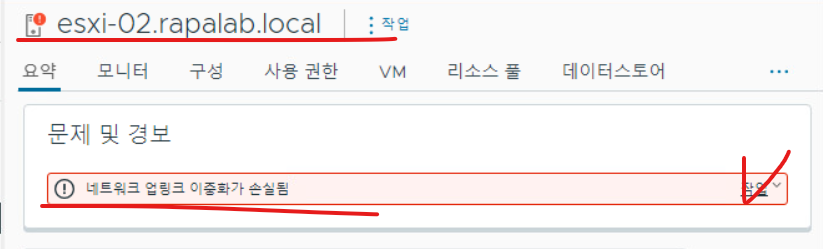

(3) 이 작업까지 완료하면 esxi-02 호스트 기준으로 업링크 이중화가 손상되었다는 오류 메시지가 확인되는데, 우측 작업을 을 누르고 녹색으로 변경 옵션을 클릭한다.

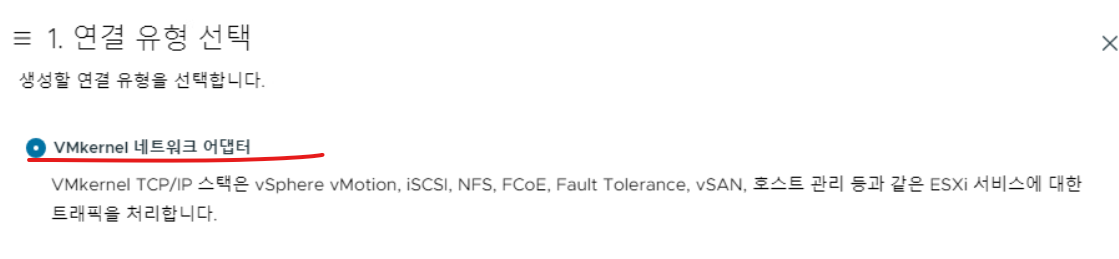

(4) 작업을 위해 새로운 스위치를 추가하는데, iSCSI와 통신을 위한 VMKernel 네트워크 어댑터를 지정한다.

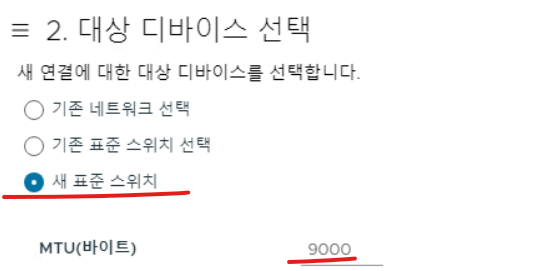

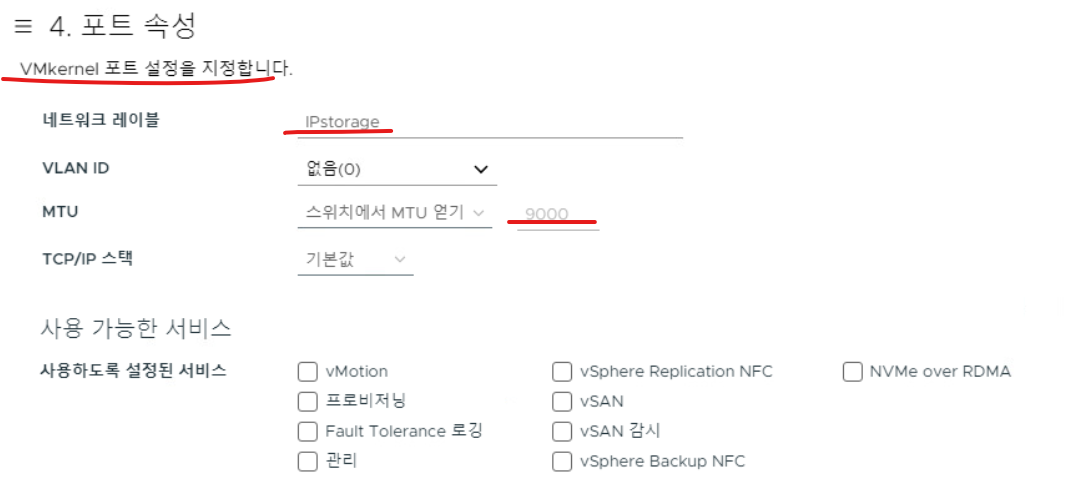

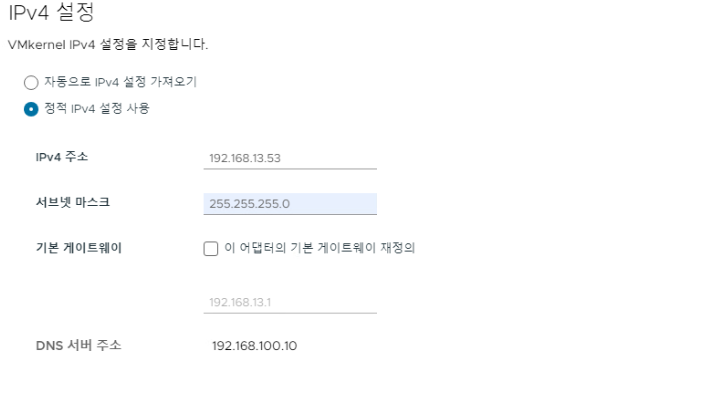

(5) 새 표준 스위치를 선택하고 MTU Size는 9000으로 준다.

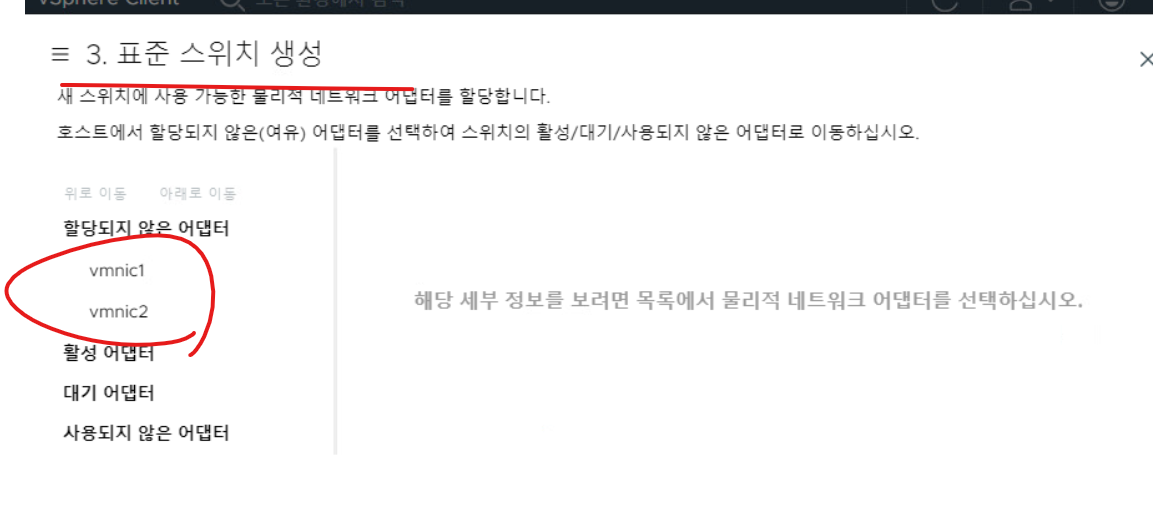

(6) 새로운 스위치에 대해 할당되지 않은 VMNIC가 확인된다.

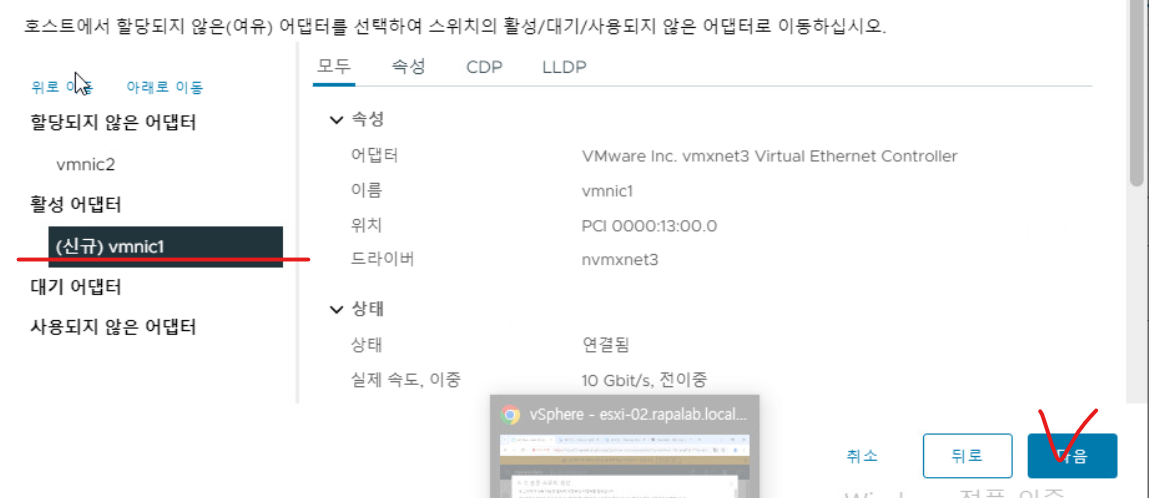

(7) VMNIC1 인터페이스를 통신에 사용하기 위해 활성 어댑터로 이동한다.

(8) VMNetwork의 네트워크 레이블명은 IPStorage로 설정한다.

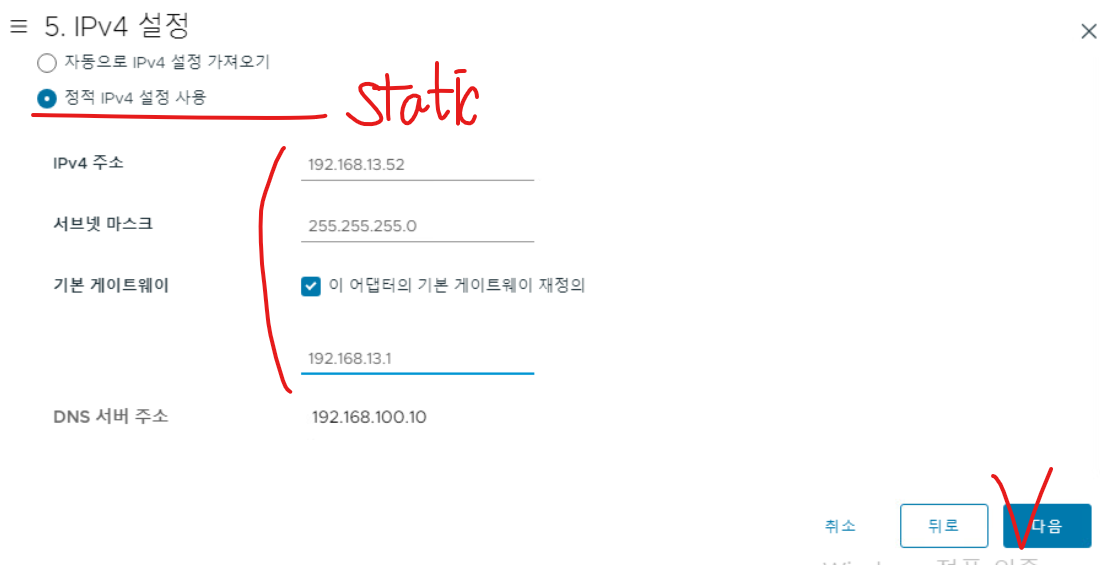

(9) 스토리지 VMKernel의 주소 대역은 실습 토폴로지를 참고하면 esxi-02 host 기준으로 위와 같다.

(10) 새로운 가상 스위치 생성을 완료한다.

(11) iSCSI 통신을 위한 가상 스위치에 어댑터 포트가 할당된 것을 확인할 수 있다.

(12) 토폴로지를 보면 위와 같다.

(13) esxi-02 호스트 v-Switch01의 보안 설정은 모두 허용 옵션으로 변경한다.

8-6. IP Storage와 ping test가 수행되는지 확인 : IPStorage VM에서 진행

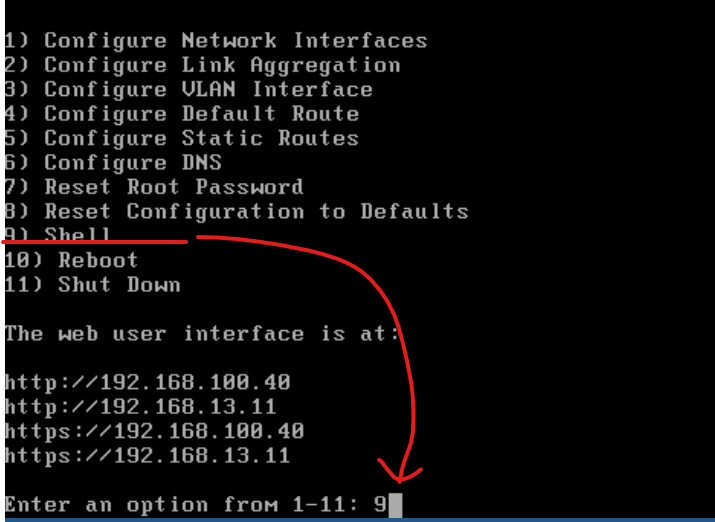

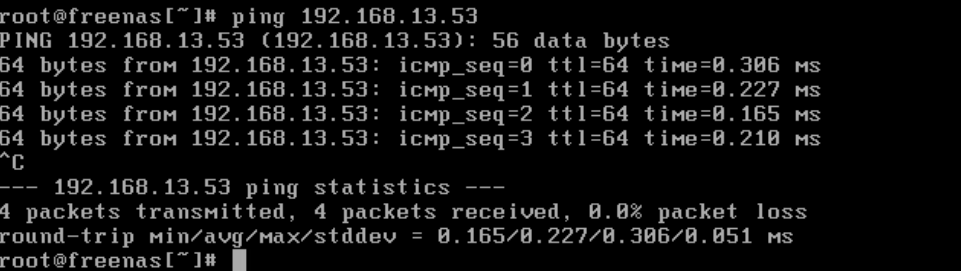

(1) 9번 옵션을 적용해서 콘솔을 열고 esxi-02 호스트의 VMKernel 주소 대역으로 ping을 수행해 보면 정상 수행된다. iSCSI 통신이 가능하다는 의미를 갖는다.

8-7. iSCSI 디스크로 인식할 수 있도록 하는 작업 필요 : iSCSI 드라이버 적용 & 디스크 인식 후 공유 데이터 스토어 생성 (ESXi-03 호스트에도 VMKernel 네트워크를 열고 공유 데이터 스토어를 받게 함.)

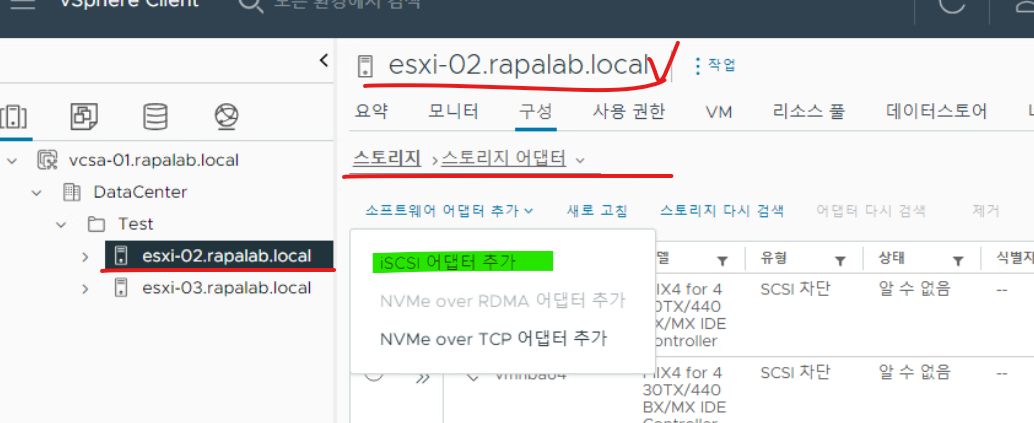

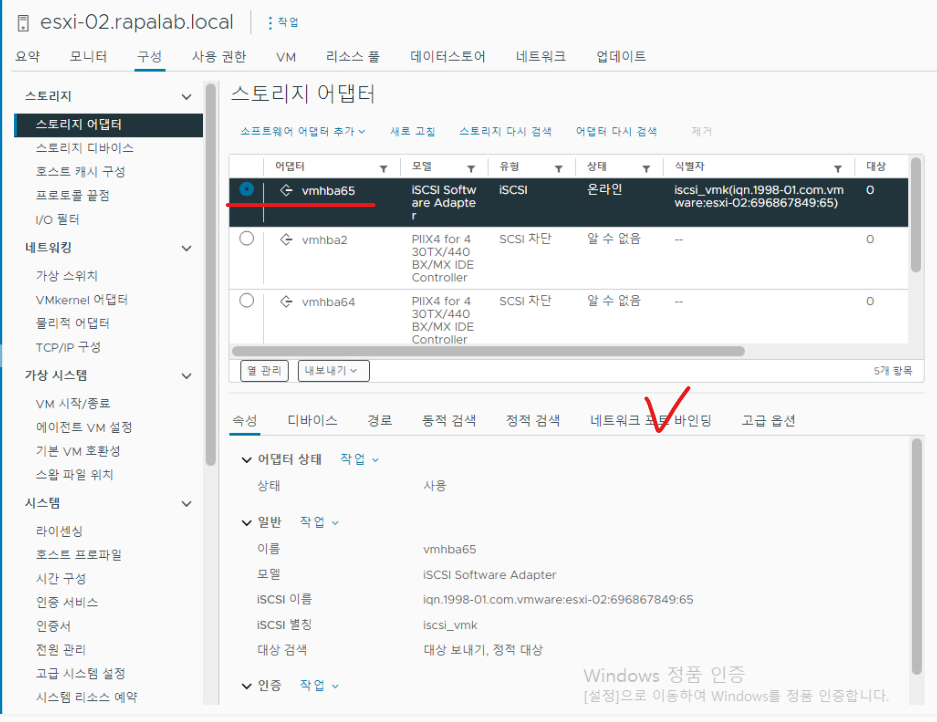

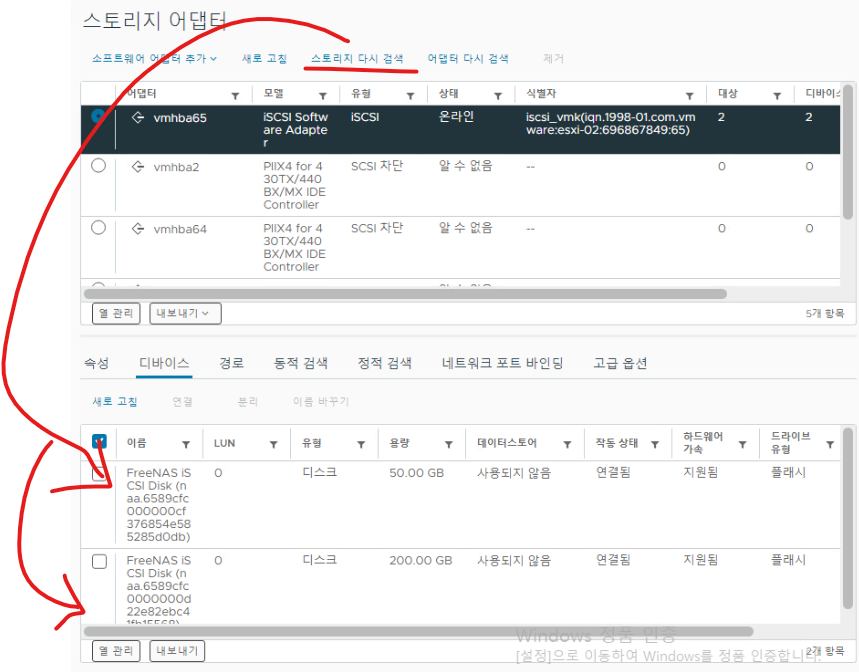

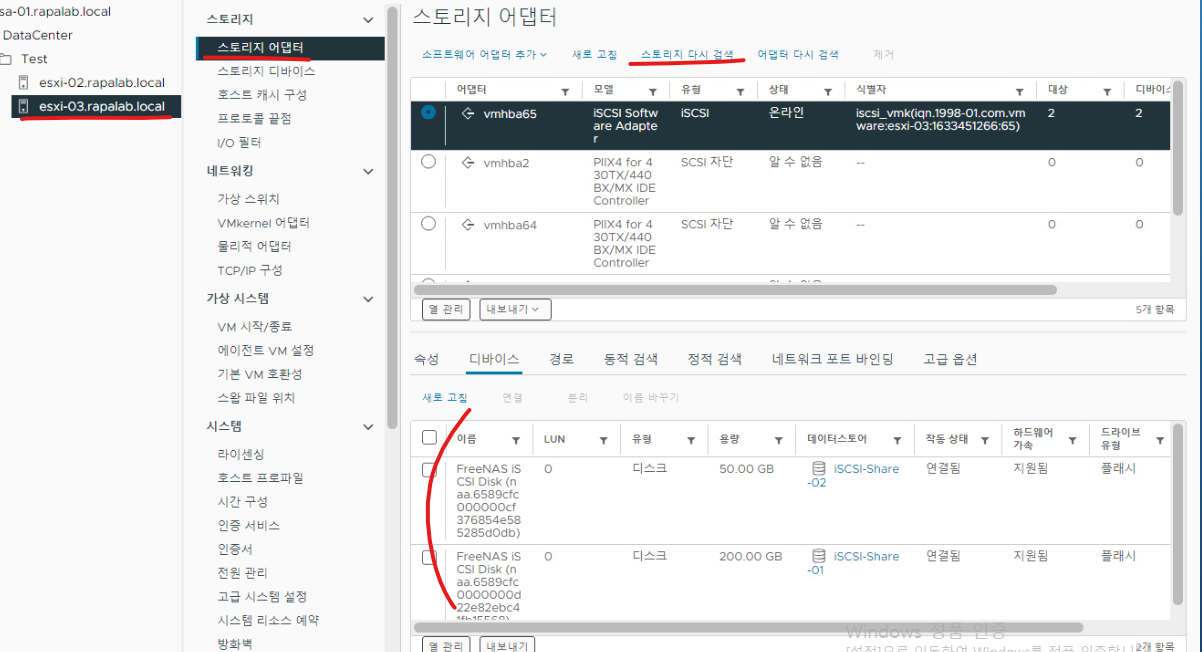

(1) esxi-02 호스트를 기준으로 스토리지 > 스토리지 어댑터 항목을 통해 iSCSI 디스크를 인식할 수 있도록 드라이버를 인식시켜야 한다.

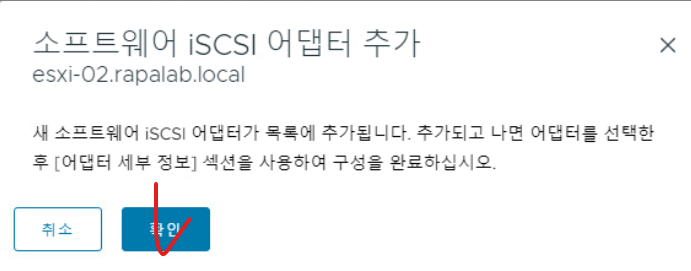

(2) 확인으로 넘어간다.

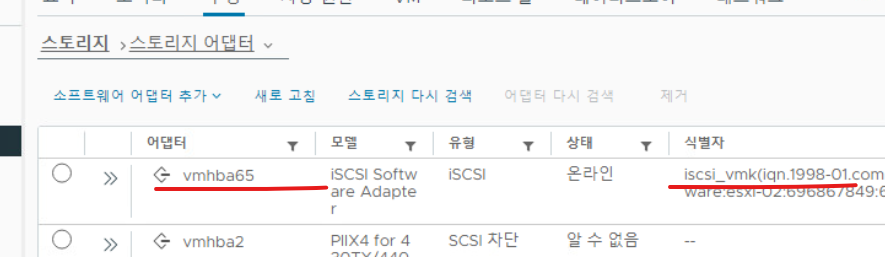

(3) 확인을 누르면, 해당 어댑터가 iSCSI를 인식하기 위한 드라이버 영역이고 새로운 드라이버가 생성된다.

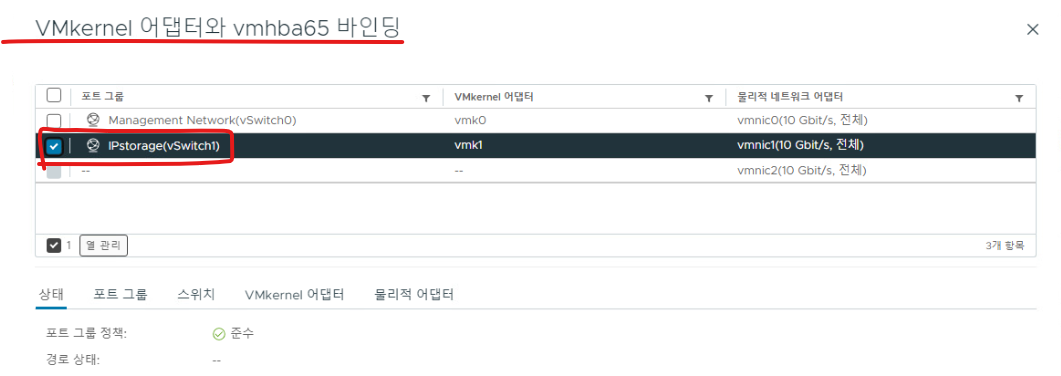

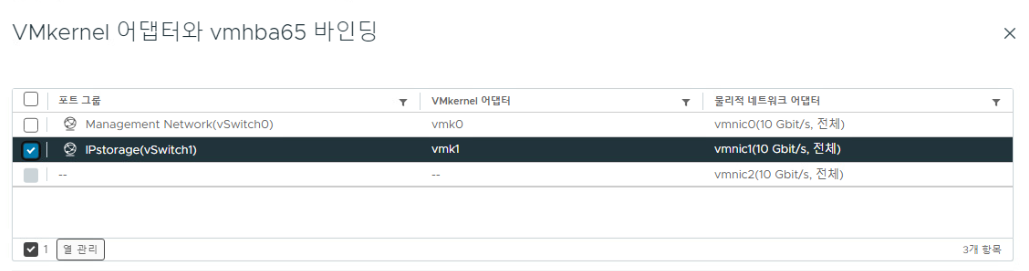

(4) 이전에 만든 가상 스위치의 NIC와 iSCSI 드라이버를 여기서 연결한다. (네트워크 포트 바인딩)

(5) VMKernel에서 설정한 통신 포트를 iSCSI 어댑터 드라이브와 바인딩한다.

(6) 바인딩이 완료되면 VMKernel 포트가 인식된다. (ESXi-02 Host 기준)

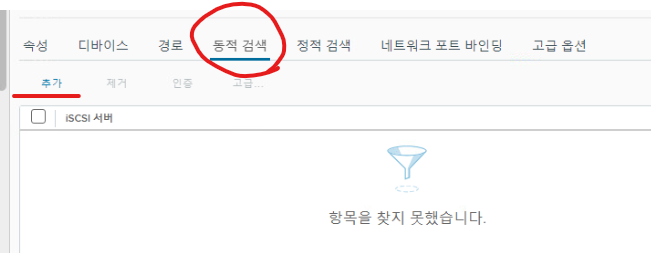

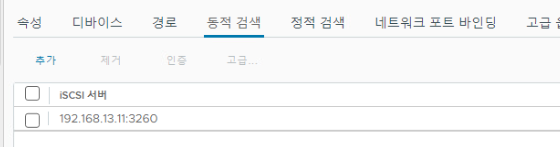

(7) 이후 iSCI (IP Storage) 가상 머신을 인식하기 위한 동적 바인딩이 필요하다. / 동적 검색 항목에서 추가 버튼을 누른다.

(8) 송신 대상 서버 추가에서 IP Storage가 사용하는 주소 대역을 입력하고 확인을 누른다.

(9) 동적 바인딩 경로에 IP Storage에서 사용하는 주소와 포트 번호가 확인된다.

(10) 해당 메뉴 상단 버튼인 "스토리지 재검색"을 누르면 디바이스 항목에 iSCSI 디바이스가 정상 인식된다.

- 만약 디바이스가 확인되지 않는다면 FreeNAS에서 볼륨 생성 과정에서 문제가 발생한 것.

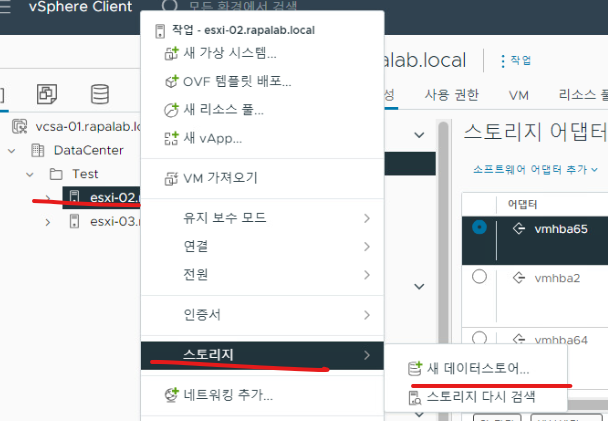

(11) esxi-02 호스트 기준으로 스토리지 > 새 데이터 스토어 메뉴를 클릭한다

(12) 현재 작업은, IP Storage VMs에서 생성한 디스크 인스턴스를 iSCSI 드라이버를 통해 인식한 상태이므로 데이터스토어로 생성하기 위해 접속하는 메뉴다.

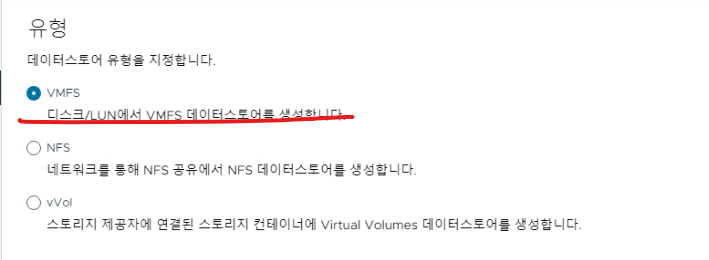

(13) VMFS 유형을 선택한다.

(14) 200GB 공간을 갖는 iSCSI 디스크 인스턴스를 선택한다.

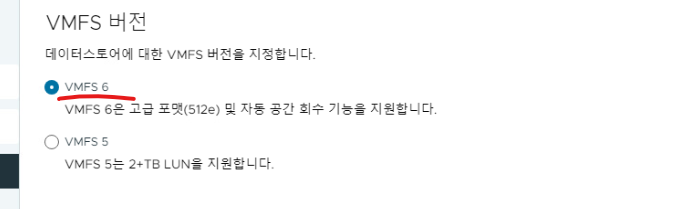

(15) VMFS 최신 버전을 선택한다.

(16) 전체 파티션을 사용할 수 있도록 파티션 구성을 설정해 주고 다음으로 넘어간다.

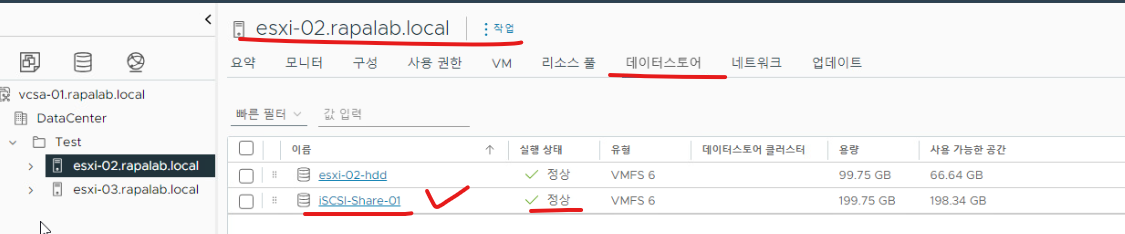

(17) 설정 디바이스를 기반으로 하는 데이터 스토어가 생성된 것을 확인할 수 있다.

(18) 나머지 디바이스 인스턴스(50GB)도 데이터 스토어로 인식시키기 위한 작업을 위와 같이 동일하게 수행한다.

(19) 나머지 공간에 대한 인스턴스도 데이터 스토어 형태로 확인된다.

(20) 현재 ESXi-03 호스트 기준으로는 가상 스위치 & 가상 스위치에서 물리적 NIC를 통해 IPStorage와 통신할 수 없으므로 DELL 서버의 ESXi 호스트에서 해당 호스트를 종료하고 새로운 NIC 인터페이스 2개를 추가한다.

(21) 실무 환경에서는 기타 사용자들이 서버를 사용 중일 수 있으므로 전원을 바로 끄면 안 된다. 이 부분은 주의한다.

(22) 물리적 NIC를 2개 추가한다.

(23) VMNIC1, VMNIC2가 활성화된 것을 확인할 수 있다.

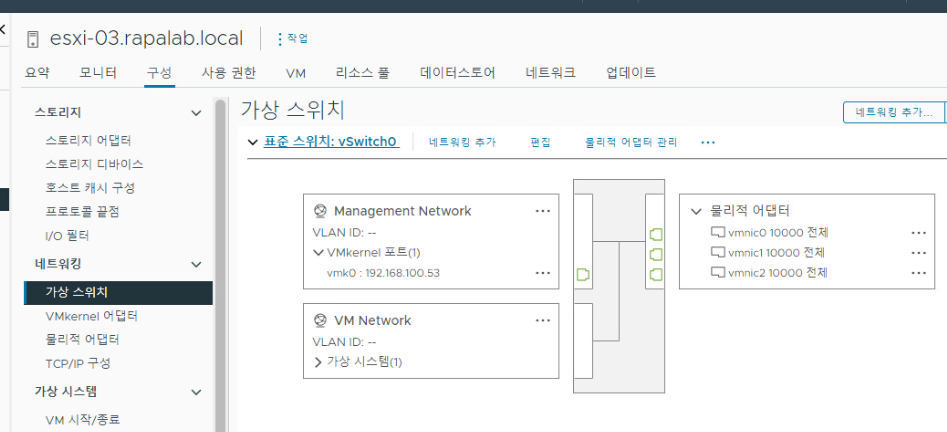

(23) vSwitch0 설정으로 접속해서 방금 활성화된 포트 2개를 할당되지 않은 어댑터 옵션으로 변경한다.

(24) 이후 새로운 vSwitch1을 생성하는데 VMKernel 네트워크로 위와 동일하게 잡고, esxi-03의 IP Storage VMKernel 주소 대역을 설정한다.

(25) 이후 새로운 스위치가 생성됨을 확인한다.

(26) ping test를 통해 esxi-02 호스트에서 생성한 VMKernel 포트와 통신 가능한지 확인한다.

(27) 이후 ESXI-03 호스트를 기준으로도 스토리지 어댑터를 추가한다.

(28) 03의 호스트에 존재하는 VMKernel의 통신 포트와 iSCSI 어댑터 드라이브를 바인딩한다.

(28) 스토리지 통신을 위한 주소 대역을 추가해 준다.

(29) 정상적으로 바인딩/ 추가되었다면 FreeNAS 디바이스가 모두 인식되어야 한다.

(30) ESXi-03 호스트를 기준으로 디바이스에 대한 데이터 스토어가 모두 인식된다.

※ 해당 포스팅을 기준으로 내용 추가가 필요하다고 생각되면 기존 내용에 다른 내용이 추가될 수 있습니다.

개인적으로 공부하며 정리한 내용이기에 오타나 틀린 부분이 있을 수 있으며, 이에 대해 댓글로 알려주시면 감사하겠습니다!

댓글